剛剛過去的周末,光伏、儲能行業迎來重磅(páng)利好消(xiāo)息:摩根(gēn)士丹利調高寧德時(shí)代目標價,在黃仁勳、奧特曼兩位大佬加持下“儲能與AI”的故事發酵。

圖片來源(yuán)網(wǎng)絡

摩根士丹利調高寧德(dé)時(shí)代目標(biāo)價

3月(yuè)10日,摩根(gēn)士丹利發(fā)布報告,將(jiāng)中國電池(chí)巨頭寧德時代(CATL)的評級上調至“超配”,並設定目標價為210元人(rén)民幣。在報告中,摩根士丹利分(fèn)析師指出(chū),寧德時代作為全球領先的電(diàn)池製造商,受益於電動汽車市場的快速增長和電池需(xū)求的攀升。

摩根士丹利發布(bù)報(bào)告指出,隨著價格戰接近尾聲,寧德時(shí)代準備通過新(xīn)一代大規模生產線提高成本效率,並擴大在淨資產收益率方麵的優(yōu)勢,看到寧德時代在基本麵上的多個拐點,上調公司評(píng)級(jí)至(zhì)超配,並選(xuǎn)為(wéi)行業(yè)首選。

另外,據央視網10日報道(dào),寧德時代董事長曾(céng)毓群在(zài)采訪時談到了近期多家歐美車企削減或推(tuī)遲電動化的話題,“歐美車企沒有回歸燃油車,也沒有(yǒu)停止(電動汽車),可能是因為不賺錢(qián),所以往後延遲一陣。”

從儲能業務來看,寧德時代是當之無愧的王者。國海證(zhèng)券預計,該公司2023年動(dòng)力和儲能電(diàn)池的出貨量達380GWh以上,同比增長(zhǎng)31%以上。單2023年(nián)四季度看,公司的出貨量達(dá)110GWh以上,同比增(zēng)長14%以上,環(huán)比增(zēng)長10%以上。按四季度中值計算,假(jiǎ)設公司的電池(chí)業務利潤貢獻(xiàn)在90%,則測算公司單Wh盈利在1毛左右,與公司2023年前(qián)三季度的單位盈利基本保(bǎo)持相當。

黃(huáng)仁勳(xūn)、奧特曼:AI的(de)盡頭(tóu)是光伏和儲能

消息麵上(shàng),在算力爆炒之後,“儲能+AI”的故事在剛(gāng)剛過去的這個周末發酵了。據報(bào)道,英偉達(dá)CEO黃仁勳在一(yī)次公開演講中指出,AI未來發展與狀和儲(chǔ)能緊密相連。黃仁(rén)勳在演講中明確表示:“AI的(de)盡頭是光(guāng)伏和儲能!我們不能隻想著算力,如果隻考慮計算機,我們需要燒掉14個地球的能源。”

早在2月27日,就有人在(zài)社交視頻上講“儲(chǔ)能與AI”的故事(shì),引用的也是所謂“黃仁(rén)勳的(de)演講”。與此同時(shí),OpenAI的創始人山姆(mǔ)·奧特曼也提出了類似(sì)的看(kàn)法。奧特曼(màn)表示,“未來AI的技術取決(jué)於能源,我們需要更多的光伏和儲能。”

ChatGPT日耗(hào)電超50萬度

人工智能技術的快速發展,帶來了巨大的算力和能源消(xiāo)耗。據(jù)《紐約客》雜誌報道(dào),ChatGPT日耗電超50萬度,相當(dāng)於1.7萬個美國家庭,以響應用戶的約2億個請求。

*近,在博世互聯2024大會上(shàng),馬斯克遠程連線接受(shòu)了博世CEO和董(dǒng)事長的采訪。馬斯克提到人工智能的發展速度前所未見,似乎每過6個月的時間,算力就會增加10倍,遠遠超出了摩爾定律每18個月翻番(fān)的速度。他預計,兩(liǎng)年(nián)內(nèi)年將(jiāng)由“缺矽”變為“缺電”,而這可能阻礙AI的(de)發展。

“目前算力增(zēng)長(zhǎng)已(yǐ)經麵臨瓶頸,很明顯,接下來變壓器會陷入短缺,緊接著(zhe)就(jiù)是電力(lì),等到2025年,我們將(jiāng)沒有足夠的電力(lì)來運行所有的芯片。”馬(mǎ)斯克稱。

事實上,馬斯克對(duì)電力短缺的擔憂也不是一天(tiān)兩天了,此前曾多次公開強調解決日益增(zēng)長(zhǎng)的電力需求的緊迫性。他認為,需要加快項目進度,以跟上不斷增長的電(diàn)力需求。

我國台灣地區4月電價調漲箭在弦上,“電價工作小組”3月12日起將連開4場討論會。其(qí)中民(mín)生用電擬(nǐ)分三級(jí)距調漲,*小漲幅700度(或500度(dù))以下約漲5%,701~1000度約漲7%,1001度以上漲約10%;產(chǎn)業用電依產業別分三級距調漲,但連二年用電成長、用電50億度以上“超(chāo)級大戶”以公司別來看,調幅*高上看近3成,台積電首(shǒu)當其衝;但用電衰退麵板、石(shí)化(huà)、鋼鐵,漲幅較小。4月電(diàn)價方案平均漲幅在10~15%。

波士頓谘詢公(gōng)司就曾分析稱,預(yù)計2030年左右,美國數(shù)據中(zhōng)心的電力消耗將較2022年增長三倍,相當於電力總需求的7.5%,會(huì)大幅提升社會用電量。

谘(zī)詢公司Grid Strategies也曾發布過一項研究,認為(wéi)美國未來(lái)五年的年度電力需求增長大約在1.5%左右。而根據EIA的數據,美國發電量近15年來才增加了不到3%。過慣了供需相對穩(wěn)定日子的(de)美國供電體係,和麵臨不少問(wèn)題的電網,能否(fǒu)應對驟然增長(zhǎng)的需求,尚有待(dài)觀察。

從儲能業務來看,寧德時代(dài)是當之無愧的王者。國海證券預計,該公司2023年動力和儲能(néng)電池的出貨量(liàng)達380GWh以上,同比增長31%以上。單2023年四季度看,公司的出貨量達110GWh以(yǐ)上,同比增長14%以上,環比增長10%以上。按四季度中值(zhí)計算,假設(shè)公司的電池業務利潤貢獻在90%,則測算公司單Wh盈利(lì)在(zài)1毛左右,與公司2023年(nián)前三季度的(de)單位盈利基(jī)本保持相當。

AI大模型下的液冷發展趨勢

摘要

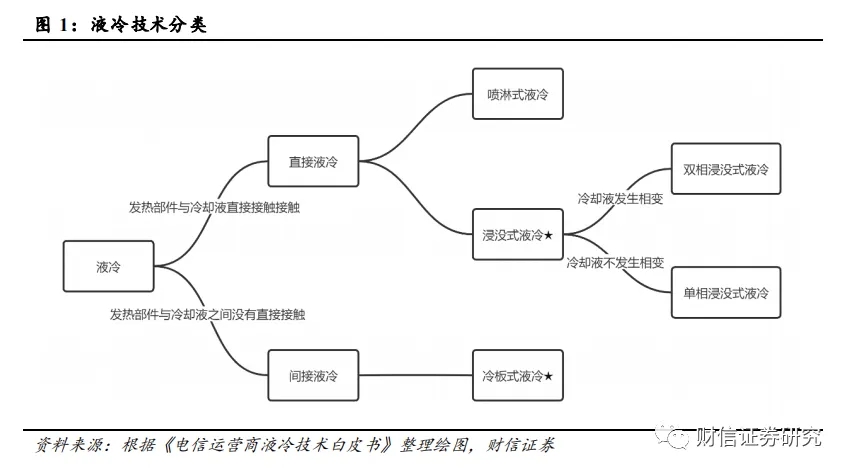

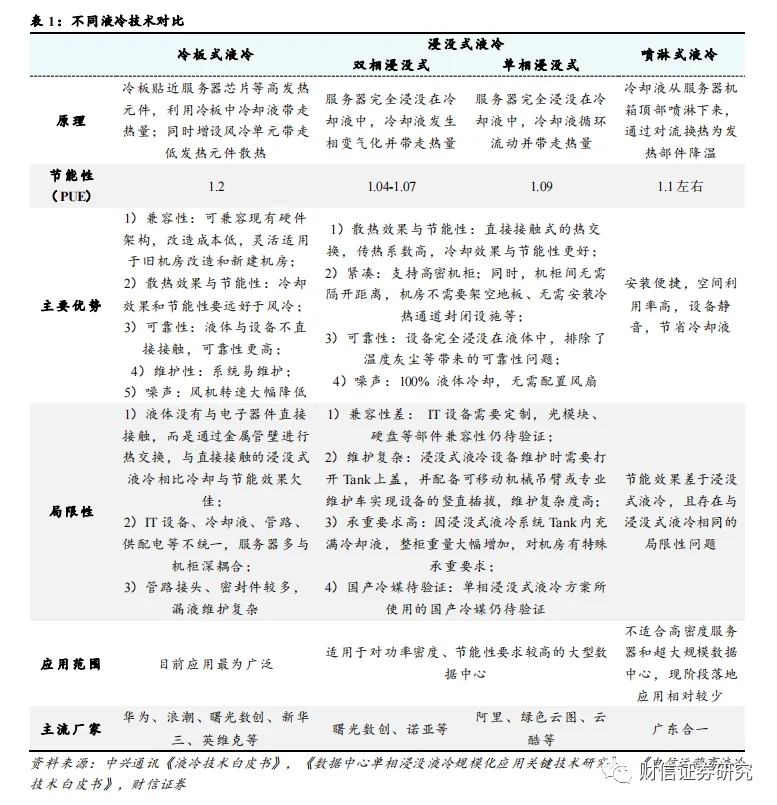

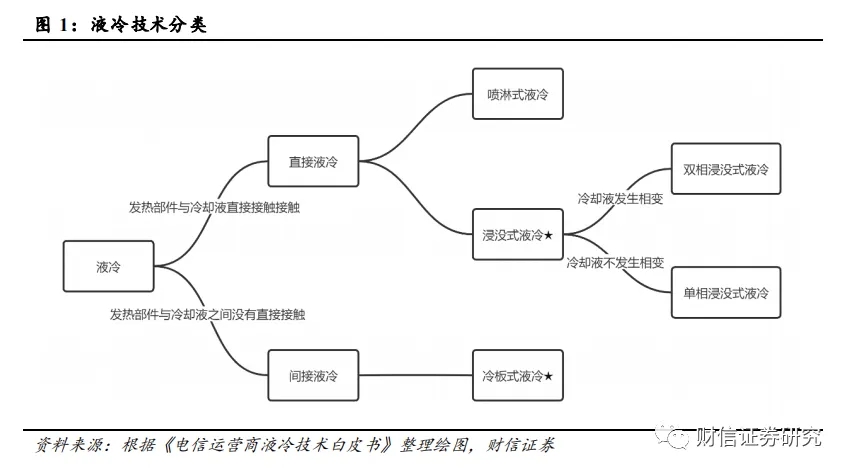

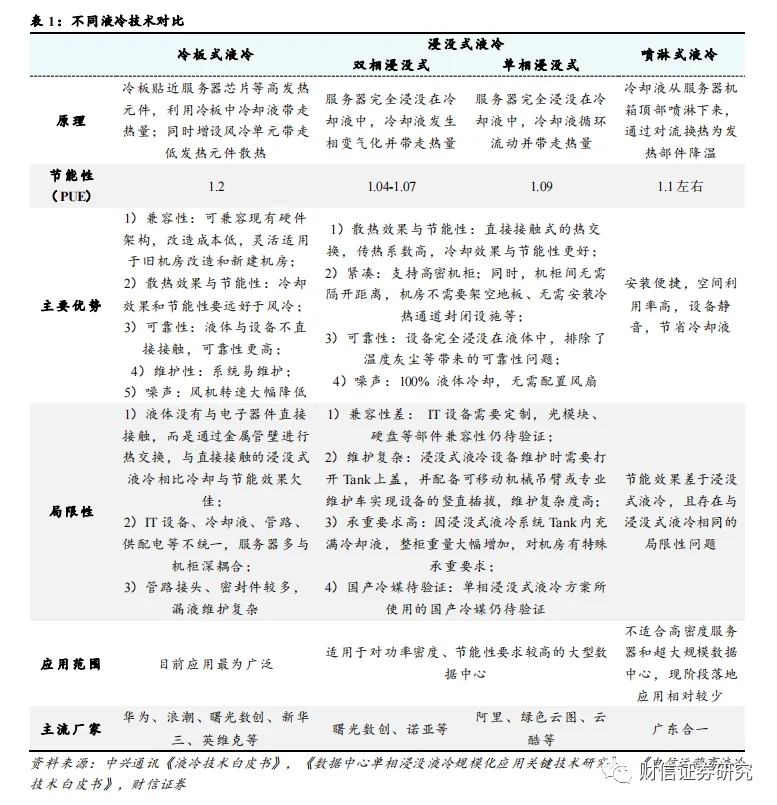

液冷(lěng)是一種用液體來冷卻電子設備的(de)散熱技術,能夠顯著提高數據中心散熱效率。液冷(lěng)技術根據冷卻液與發熱器件的接觸方(fāng)式(shì)不同,可以分為間接液冷和直接液冷,其中間接液冷主要包括冷板式液冷,直接液冷包括浸沒式液冷和噴淋式液冷。冷板式液冷和(hé)浸沒式液冷是(shì)目前主(zhǔ)流的液冷形式,冷板式液冷應用*為廣泛,在改造成本、可維(wéi)護性、兼容性方麵(miàn)具備優勢;浸沒式液冷冷(lěng)卻效(xiào)果(guǒ)*好,節能性上優勢明顯,但可維護性和(hé)兼容性一般,多(duō)用於高功率密度(dù)機櫃。

控製當前數據中心溫控方式仍以風冷為主,液冷方案中冷板式技術更為(wéi)普(pǔ)及。2022年數據(jù)中心液(yè)冷技術的滲透率大概在(zài)5%~8%左右,風冷仍然占據90%以上的市場份額。按照服(fú)務器出貨量(liàng)口(kǒu)徑統計,2023H1我國冷板式液冷服務(wù)器(qì)比例(lì)為90%左右(yòu),浸(jìn)沒式液冷滲透率為10%。

數據中心算力與能耗水漲船高(gāo),逐漸超出風冷散熱閾值,液冷散熱已是趨勢所向。Chatgpt為代表的生成式人工智能模型拉升算力需求,百億參數成為模型湧現門(mén)檻,算(suàn)力成為大模型性能提升(shēng)的關鍵。大模型帶來大算力,大算力帶來高功耗,Intel的多款(kuǎn)CPU芯片的(de)TDP已突破(pò)350W,NVIDIA 的H100係列GPU芯片TDP更是達到700W。這(zhè)也導致單服務器和單機櫃功率均顯著上升,已經逐漸超出風冷散熱的覆蓋範圍,液冷散熱已成(chéng)為(wéi)必然趨勢。

PUE限製是現階段液冷技術(shù)發展的核心(xīn)驅動(dòng)力。PUE代表數(shù)據中心能源使用效率(lǜ),等於數據中(zhōng)心總耗電/IT設備耗電,比(bǐ)值越接(jiē)近於1,說明能源越接近全部都用於(yú)IT設備負載(zǎi)上。我國(guó)數據中心平均PUE為1.49,仍有半數區域的數據中(zhōng)心PUE位於1.5以上。近幾年,國家與地方出台了一係列針對新建與老(lǎo)舊數據中心PUE的管控計劃,明確要求東、西部樞紐節點(diǎn)數據中心PUE分別(bié)控製在(zài)1.25、1.2以(yǐ)下。而傳統(tǒng)風冷方案(àn)的數據中心PUE一般在1.5左右,高於政策要求的範圍;液冷方案能(néng)夠有效降低(dī)冷卻係統的能耗水平,從而將數據(jù)中心整體PUE降低到1.05-1.2左右,滿(mǎn)足相(xiàng)關的政策要求。

數據中心TCO是液冷(lěng)技術(shù)規模應用的關鍵因(yīn)素。數據中心總成本(běn)(TCO)包(bāo)括建設成本(Capex)和運營成本(Opex)。根據奕信通科技在2022年數據中心標準峰會發布的報告(gào)進行測算(suàn),以華東地(dì)區數據中心建設情況為例,現階段冷板式液冷方案的TCO甚至Capex已經低(dī)於(yú)風冷,浸沒式(shì)液冷方案的TCO也將在運行五年左右之後(hòu)出現低於風(fēng)冷方案的拐點。但是該測算結果依賴於一(yī)定的前提條件:如機(jī)櫃功率達到30KW、不計算服務器折舊和服務器運營支出、水電費與房(fáng)租等運(yùn)營成(chéng)本按華東地區(qū)情況計價、采用集中式大型IDC機房且IT設備在12個月線性上架後實現80%負載率、外界氣溫對製冷係統的能耗需求較高等。因此在西北部地區、較小型數據中心等場景下液冷技術的經濟性尚沒有完全體現。但在數據中心發展的大型化、集約化的趨勢下,且液冷方案仍存在每年降本5-10%的空間,再考慮到液冷方案(àn)能夠有效延長服務器使用壽(shòu)命,未來液冷數(shù)據中心TCO的優勢將更(gèng)加明顯。

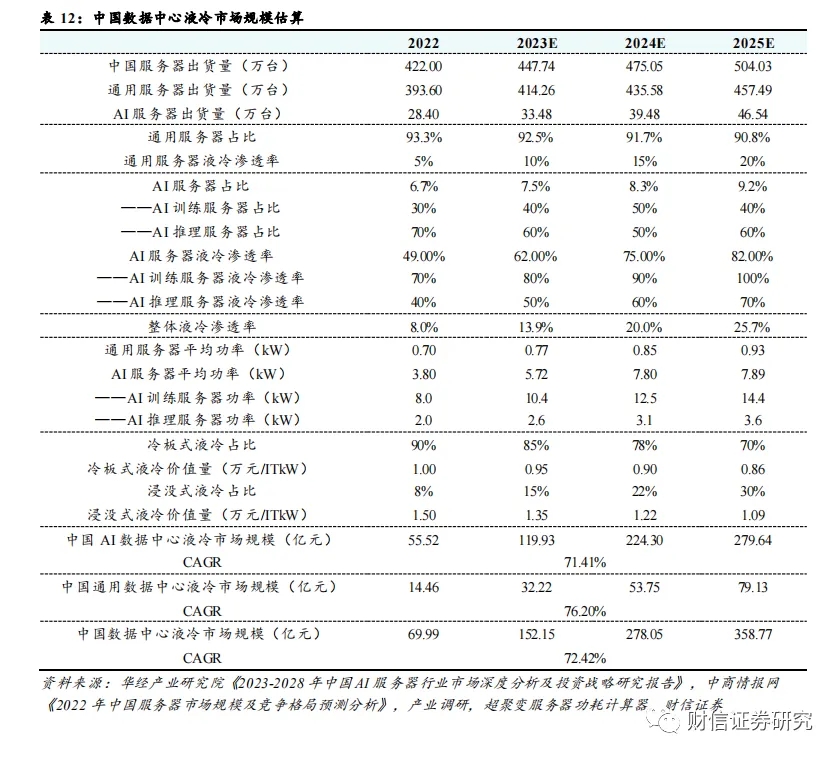

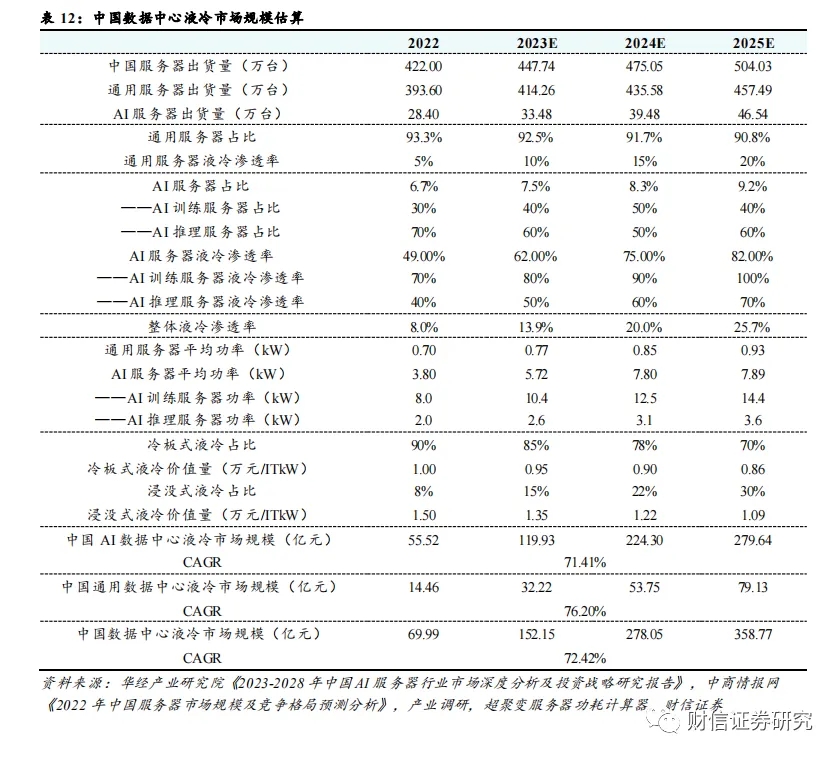

控製(zhì)數(shù)據中心液(yè)冷未來市場規模估算:到2025年,中國(guó)數據中心液冷市場規模將達到359億元左右,CAGR達到72.4%;AI數據中心液冷市場規模將達到280億元左右,CAGR達到71.4%;通用數據中心液冷(lěng)市場規模將達到79億元,CAGR達到76.2%。

1液冷(lěng)技術詳解

液冷是一種用液體來冷卻電子設備的散熱技術。液冷的工作原理(lǐ)是以液體作為冷媒,利(lì)用液體(tǐ)的高熱容和高熱傳導性能,通過液體流動將IT設備的內部元器件產(chǎn)生的(de)熱量傳遞到設備外,使IT設備的發熱器件得到冷卻,以保證IT設備在安全溫度範圍(wéi)內運行(本文主要討(tǎo)論數據中心應(yīng)用(yòng)場景下的液冷技術)。根據冷卻液與(yǔ)發(fā)熱器件的(de)接觸方式不(bú)同(tóng),可以分為間接液冷(lěng)和直接液冷。間接液冷是指服務器熱(rè)源與冷卻(què)液之間沒(méi)有直接接觸的換熱過程,以冷板式液冷(lěng)技(jì)術為主。直接(jiē)液冷是指(zhǐ)將發熱部件與冷卻液直接接觸的冷卻方式,包括浸沒式和噴淋(lín)式液冷技術。其(qí)中(zhōng)又可以根據冷卻液(yè)是否會(huì)發生液態到氣態的轉變,將浸沒式液冷分為單相浸沒式液冷和雙相浸沒式液冷。當前,冷板式液冷(lěng)和浸沒式(shì)液冷為液冷的(de)主要形式。

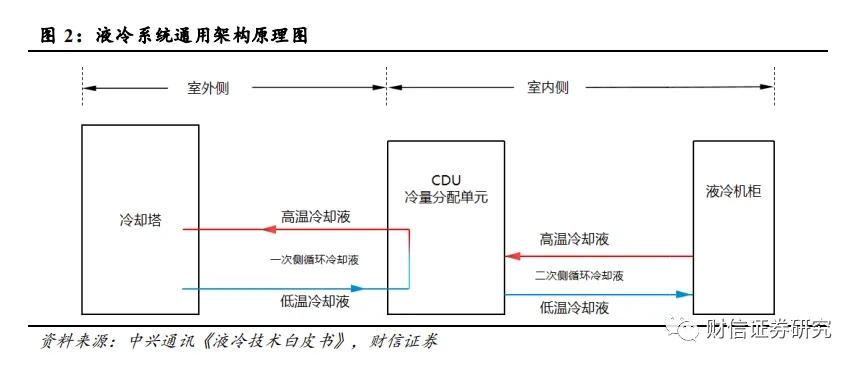

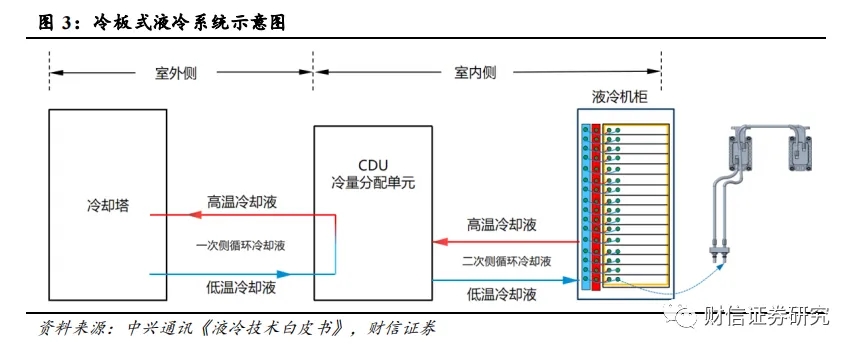

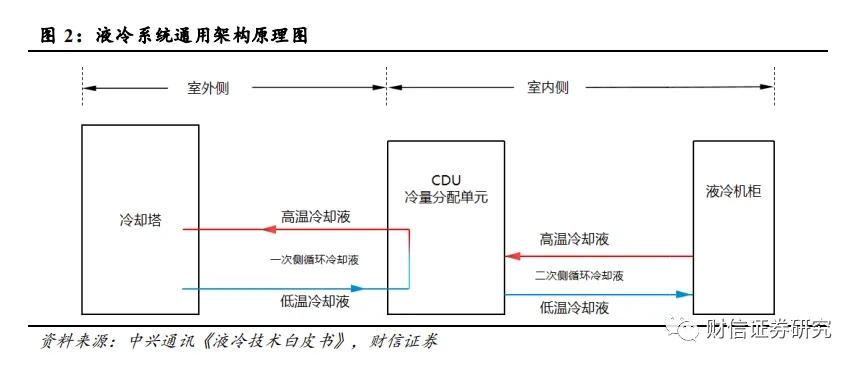

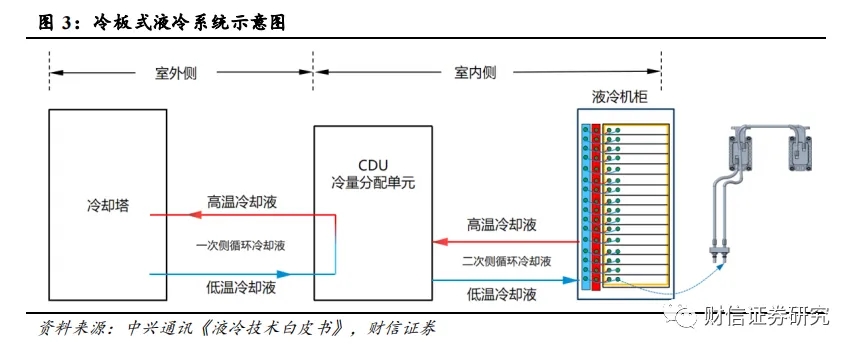

液冷係統通用架構包括室外(wài)側和室內側兩(liǎng)部分:室外側包含(hán)冷卻塔、一次側管網(wǎng)、一(yī)次側冷卻液;室內(nèi)側包含 CDU、液冷機櫃、ICT 設備、二次側管網和二次側冷卻液。室外側為外部冷源,通常為室(shì)外的冷水機組、冷卻塔或幹冷器,熱量轉移(yí)主要通過水溫的升降實現;室內側包括供液環路和服務器內部流道,主要通過冷卻液(yè)溫度的升降實(shí)現熱量轉移;兩個部分通過CDU中的板式換熱器發(fā)生間壁式換熱。

1.1 冷板式液冷

冷板式液冷屬於間接液冷,冷卻液不與服務器芯片(piàn)直接接(jiē)觸。冷(lěng)板式液冷也被稱作芯片級(jí)液冷,技術原理是通過在服(fú)務(wù)器組件(如 CPU、GPU等高發熱部(bù)件(jiàn))上安裝液冷板(通(tōng)常為銅鋁等導熱金屬構成的封閉腔體),服務器組件通過導熱部件將熱量傳導到液冷板上,然後利用液(yè)冷板內部的液體循環將熱量傳遞到(dào)遠離服務器的散熱單元;同時(shí)一般會增(zēng)設風冷單元為低發熱元件進行散熱。

冷板式液冷係統主要(yào)由冷卻塔、CDU、一次側 & 二次側液(yè)冷管路、冷卻介(jiè)質、液冷(lěng)機櫃組成;其中液冷機櫃內包含液冷(lěng)板(bǎn)、設備內液冷管(guǎn)路、流體連接器、分液器等。

1.2 浸沒式液冷

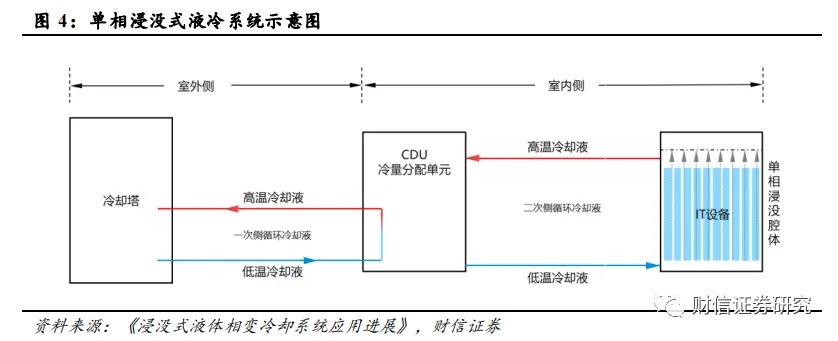

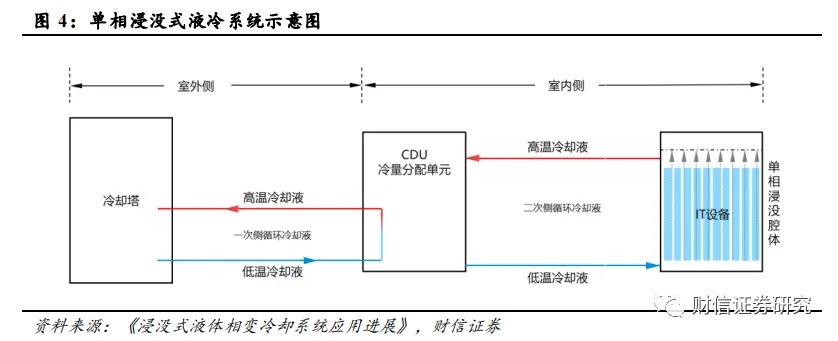

浸沒式液冷屬(shǔ)於直接液冷(lěng),將發熱(rè)器件浸沒在冷卻液中進行熱交換,依靠冷卻液流動循環帶走熱量。

浸沒式液冷係統室外(wài)側包含冷卻塔、一次側管網、一次側冷卻液;室內側包含 CDU、浸沒腔體、IT 設備、二次(cì)側管網和二次側冷卻液。使用過程中 IT設(shè)備完全浸沒在二次側冷卻液中,因此二次側循環冷卻液需要采用不導電(diàn)液體,如礦物油、矽油、氟化(huà)液等。

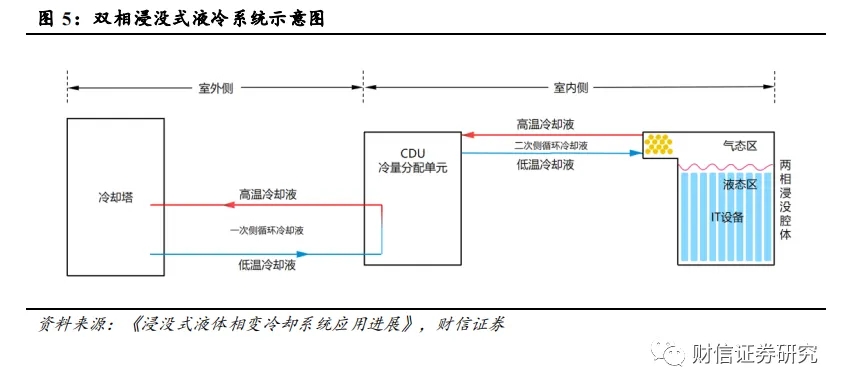

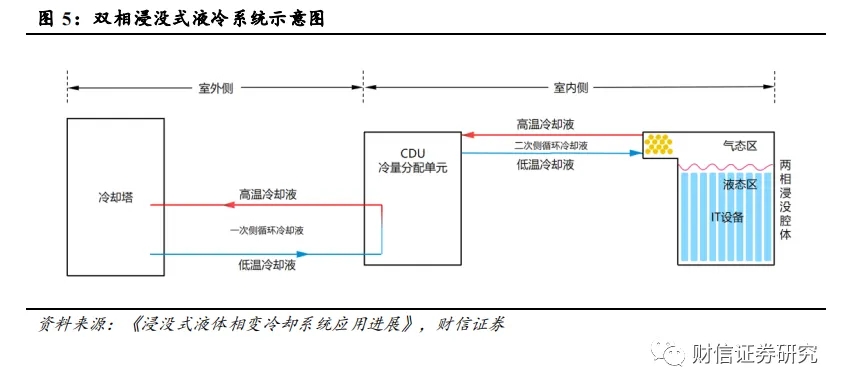

浸沒式液冷(lěng)根據冷卻液換熱過(guò)程中是否發生相變,可(kě)以進一步分為單相浸沒式液冷和雙相浸沒(méi)式液冷技(jì)術。

1.2.1 單相浸沒式液冷

在單相浸沒式液冷中,冷卻液(yè)在熱量傳遞過程中僅(jǐn)發生溫度變化,而不存在相態轉變。單相浸沒式液冷的技術原理為:CDU循環泵驅(qū)動二次側低溫冷卻(què)液由浸沒腔體底部進入,流經(jīng)豎插在浸沒腔體中的IT設備時帶走(zǒu)發熱器件熱量;吸收熱量升溫後的二次側冷卻液由浸沒腔體(tǐ)頂(dǐng)部出口流回CDU;通過CDU內部的板式換熱器將吸收的熱量傳遞給一次側冷卻液;吸熱升溫後的一次側冷卻液通過外部冷卻裝置(如冷卻塔)將熱量排放到大氣環境中,完成整個冷卻過程。

1.2.2 雙相(xiàng)浸沒式液冷

雙相浸(jìn)沒式液冷的不同(tóng)之處在(zài)於冷卻液會發生相(xiàng)態轉變。雙相浸沒(méi)式液冷的傳熱路徑與單相浸(jìn)沒液(yè)冷(lěng)基本一致,主要差異在於二次側冷卻液僅在浸沒腔體內部循環區域,浸沒腔體內頂部為氣(qì)態區、底部為液(yè)態區;IT設備完全(quán)浸沒在低沸點的液態冷卻液中,液(yè)態(tài)冷卻液吸收設備熱(rè)量後(hòu)發生沸騰,汽化產生的(de)高溫氣態(tài)冷卻液(yè)因密度較小,會逐(zhú)漸(jiàn)匯聚到浸(jìn)沒腔體頂部,與安裝在頂部的冷(lěng)凝器發生換(huàn)熱後冷凝為低溫液態冷卻液,隨後在(zài)重力(lì)作用下回流(liú)至腔體底部,實現對IT設備的散熱。

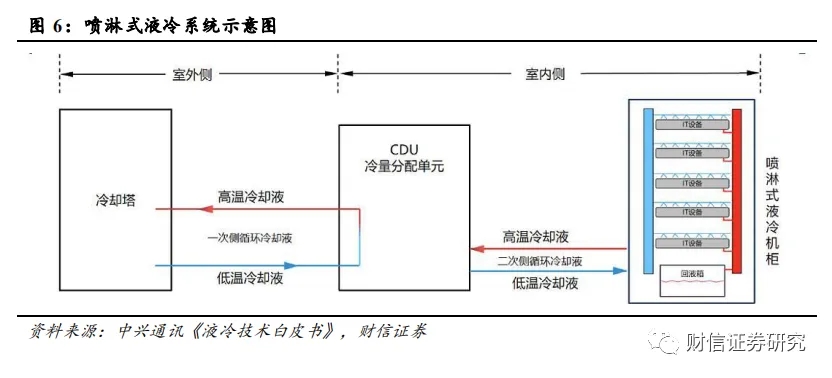

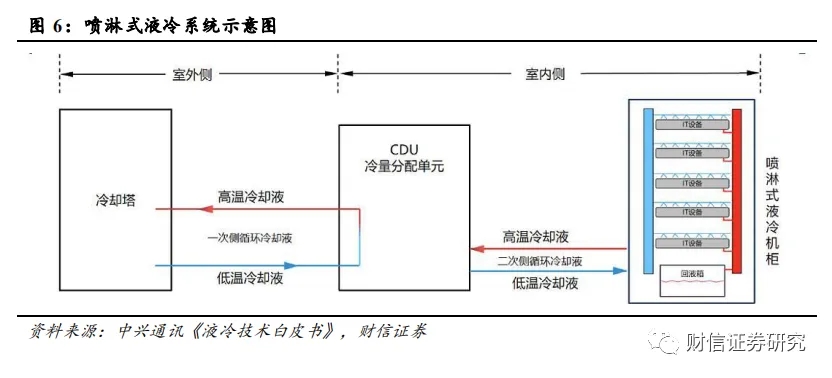

1.3 淋式液冷

噴淋(lín)式液(yè)冷屬於直接液冷,將冷卻液精準噴灑(sǎ)於電子設備器件進行散熱。冷卻液借助特(tè)製的噴淋板精準噴灑至發(fā)熱器件或與之相連(lián)接的固(gù)體導(dǎo)熱材料上,並與之進行熱交換,吸熱後的冷卻液換熱後將通過回(huí)液管、回液箱等集(jí)液裝置(zhì)進行收集並通過循環泵輸(shū)送至CDU進(jìn)行下一次製冷循環。

噴淋式液冷係統主要由冷卻塔、CDU、一次(cì)側 & 二次側液冷管路、冷卻介質和噴淋式(shì)液(yè)冷機櫃組成;其(qí)中噴淋式液冷機櫃通常包含管(guǎn)路係統、布(bù)液係統、噴淋模塊、回液係統(tǒng)等。

1.4 不同液冷方案的比較

1.4.1 冷板式液冷目前應用*為廣泛,在改造成(chéng)本、可維護性、兼容性方麵具備優(yōu)勢(shì)

冷板式液冷的優勢主要在於:

1)兼容性:冷板式(shì)液冷(lěng)的改造(zào)成本相對較低,不需要對數據中心現有的機房及機櫃進行大規模改造,其適用的硬盤、光模塊等服務器部件與風冷方案一致,運維模式、機房承重與風冷場景也基本一(yī)致;

2)散熱效果與節(jiē)能性(xìng):冷卻效果和節能性要遠好於風冷,PUE可以達到1.2左右;(據《綠色高能效數據中心散熱冷卻(què)技術研究現狀及發展趨勢》數據顯示,風(fēng)冷散熱下數據中心的 PUE 值通常在1.5左右(yòu))

3)可靠性:液體與設備不直接接觸,可靠(kào)性更高;

4)維護性(xìng):易開展維護性設計,可實現在線維(wéi)護方案;

5)噪聲:風機轉速大幅降低,噪聲值可至 70dB 左右。

冷板式液冷的局限性主要在於:

1)液體沒有與電子器件直接接觸,而是通過金屬管壁進行熱交換(huàn),與直接接觸的浸沒式液(yè)冷(lěng)相比冷卻與節能效果(guǒ)欠(qiàn)佳;

2)IT設備、冷卻液(yè)、管(guǎn)路、供配電等不統一,服務器多與機櫃深耦合;

3)管路接頭、密封件較多,漏(lòu)液維護(hù)複雜。

1.4.2 浸沒式液冷(lěng)的散熱效果和節(jiē)能性優(yōu)勢明顯,但兼容性和(hé)維護性一般,多用於高功率密度機櫃

浸沒式液冷的優(yōu)勢主要在於:

1)散熱效果與節能(néng)性:與冷板式液冷相比,浸沒式液冷中采用了直接(jiē)接觸式的(de)熱交換(huàn),傳熱係數高(gāo),冷卻效果(guǒ)更好,節能性更強(qiáng)(雙相浸沒式液冷方案的PUE在1.04-1.07左右(yòu),單相浸(jìn)沒式為1.09左右)

2)緊湊:支持高密機(jī)櫃,單櫃散熱量高達160kW;同(tóng)時,機櫃間無需隔開距(jù)離,機(jī)房不需要空調和冷(lěng)凍機組、無需架空地板、無需安裝冷熱通道封閉設施;

3)可(kě)靠性:設備完全浸(jìn)沒在液體中,排除了溫度、風機(jī)振動、灰(huī)塵等帶來的可靠性問題;

4)噪聲:100%液體(tǐ)冷卻,無需配置(zhì)風扇,實現**“靜音”機房(fáng)。

浸沒式液冷的局限性主要在(zài)於:

1)兼容性較差:IT設備需要定製,光模塊、硬盤(pán)等部件兼容(róng)性仍待驗證;此外,雙相浸沒式液冷方案適配的服務器需改為刀片式,其專用機櫃對於管路要求(qiú)高,控製複雜;

2)維護複雜:浸沒式液冷設備維護時需要打開Tank上蓋,並配(pèi)備可移動機械吊臂或專業維護車實現設備的豎直(zhí)插拔,維護(hù)複雜度(dù)高,耗時(shí)長(zhǎng);且開蓋維護過程有一定的冷卻液揮發問題,增加(jiā)運行成本;

3)承重要求高:因(yīn)浸沒式液冷係統Tank內充滿冷卻液,整櫃重量大幅增加,對機(jī)房(fáng)有特殊承重要求,普遍要求浸沒式液冷(lěng)機房地(dì)板承重應大於1500kg/m2;

4)國產(chǎn)冷媒待(dài)驗證:單相浸沒式液冷方案所使用的國產冷媒仍待驗(yàn)證。

浸沒式液冷(lěng)比較適用於對功率密度、節能性要求較高的大型數據中(zhōng)心,特別是地理(lǐ)位置較為特(tè)殊、空間有限的數(shù)據中心。

1.4.3 噴淋式液(yè)冷在(zài)安裝(zhuāng)便利性、空間(jiān)利用等方麵有優勢,但是現階段落地應用相對較少

噴淋式液冷不需要對數據中心基礎設施進(jìn)行大幅改(gǎi)動,安裝便捷,空間利用率高,且噴淋方式能夠節省冷卻液,其不足在於服務器整體密封於氣相櫃中(zhōng),排液、補液,維護時會破壞服務器原有密封結構。目前噴淋式液冷技術的應用場景有限,隻有少量數據中心采用了噴淋式液冷(lěng)技術。

2 數據中心液冷行業基本情況與競爭格局

2.1 基本情況:數據中心液冷行業如日方升,液冷技術有望(wàng)加(jiā)速導入

數據中心溫控方式仍以風冷為主,液冷技術有望加速導入。目前數據中心的散熱方式仍然以風冷為主,在算力設備以及數據(jù)中心機房的高熱密度趨勢和高能效散熱要求的雙重(chóng)推動下(xià),預計(jì)未來液(yè)冷將成(chéng)為主流的數據中心溫控方式。根據產業調研與(yǔ)曙光數創(chuàng)的信息,2022年數據中心(xīn)液冷技術的滲透率大(dà)概在5%~8%左右,風冷仍然占據90%以上(shàng)的市場(chǎng)份額;預計2025-2028年時液冷技術的滲透率有望達到30%。

液冷方式以(yǐ)冷板式為主,浸沒式技術有望加速推廣。當(dāng)前(qián)主流的液冷技術包括冷板式液冷和(hé)浸沒式(shì)液冷,由於(yú)冷板式液冷對於數據中心的改造(zào)難度較低,改造所(suǒ)需成(chéng)本(běn)也較為可控,所以目前(qián)冷板式液冷的市場應用(yòng)相對(duì)更加(jiā)普及。根(gēn)據(jù)IDC《中國半年度液冷服務器市場(2023上半年)跟(gēn)蹤》報告,按照服務(wù)器出貨(huò)量口徑統計(jì),2023H1我國冷板式液冷服務器比例達到90%左右(yòu),浸沒式液冷滲透率僅為10%。但隨著國家對(duì)於數據(jù)中心PUE的政策要求的愈發嚴格,機櫃功率密度的持續抬升以及浸沒式液冷技術的逐漸成熟,浸沒式液冷方案有望進入加速推廣期。

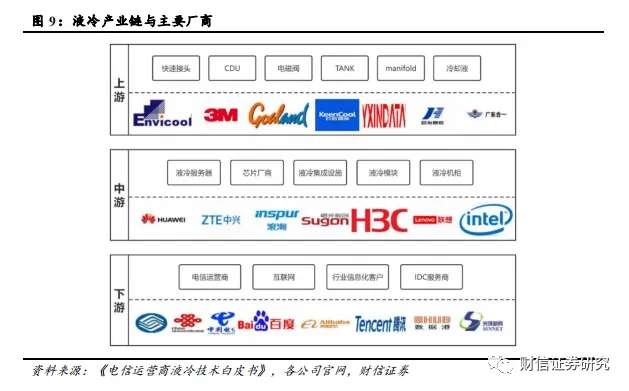

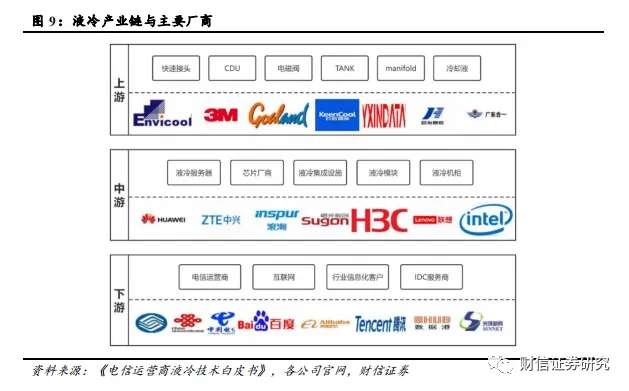

2.2 產業鏈:涉及環節眾(zhòng)多,存在(zài)較高(gāo)進入壁(bì)壘

液冷產業鏈涉及環節眾多,包括上遊(yóu)的液冷(lěng)設備及產品零部件提供商、中遊的液冷服務器及液冷基礎設(shè)施提供(gòng)商與下遊的數據中心使用者。上遊主要為產品(pǐn)零部件及液冷設備,包括(kuò)快速接頭、CDU、電磁閥、浸沒液(yè)冷TANK、manifold、冷卻液等產品,代表性廠商有英(yīng)維克、3M、高瀾股份、雲酷、奕信通、廣(guǎng)東合一、綠色雲圖、巨化(huà)股份等。中遊主要為液冷服(fú)務器、芯片廠商以及液冷集(jí)成設施、模塊與機櫃等,代表性廠商有華為、中興、浪潮、曙光、新(xīn)華三、聯想、超聚變、英特爾等。下遊主(zhǔ)要為數(shù)據中(zhōng)心的使用者,包括三(sān)家電信運營商,百度(dù)、阿裏巴巴、騰(téng)訊、京東等互聯網企業,數(shù)據港、光環新網等第三方IDC服務商以及政府、科研機(jī)構、金(jīn)融、能源(yuán)、交通等(děng)其他信息化需求客戶。

產業鏈(liàn)存在較高的技術、人才、客(kè)戶(hù)認證壁壘。

1)技術壁壘:液冷數據中心基礎設施產品的研發和製造涉及冷卻技術、製冷係統設計及(jí)仿真(zhēn)技術、溫濕(shī)度解耦控製算法等多項技術領域,要(yào)求企業在液冷核心技術進行多年研究積累,深入(rù)掌握液冷技術的相關原(yuán)理和應(yīng)用。此外,液冷數據中心(xīn)基礎設(shè)施產品工藝流程複雜,需要掌握生產製造流(liú)程中的核心工藝,同時需具備成熟的控製體係,對產品質量進(jìn)行把控,保證產品的(de)合格率,因此數據中心液冷行業具有較高的技術壁壘。

2)人才壁壘:液冷數據中心基礎設施領域屬於新興技術(shù)密集型(xíng)產業,產品性能涉及材料化學、熱力學、電子學、計算機科學等多學科,並且數據中心的製冷係統存在定製化特征,因此對研發技術人員的技(jì)術研發能力和(hé)行(háng)業經驗要求較高。目前行(háng)業發展曆程較短,技術與產品仍處於驗證階段,高端技術人(rén)才相對稀缺,且高端人才主要集中規模較大(dà)的企業以及***研究機構中,因此新進(jìn)企業難以在(zài)短期內培養出一批具備技術開發實力並擁有豐富實踐項目經驗(yàn)的專業技術隊伍,由此數據中心液冷行業存在較高的專業人才壁壘。

3)客戶認證壁壘:出於安全性、穩定性等考慮,企業客(kè)戶在選擇液冷數據中心基礎設施供(gòng)應商時通常需要進行嚴格的資質驗證。尤其(qí)是金融、醫藥等(děng)機(jī)構出(chū)於數據安全、保密等要求,對液冷數據中心基礎設施解決方案供應商挑(tiāo)選非常嚴格,需要對企業產品質量水平、項(xiàng)目經驗、技術研發能力進行綜合考(kǎo)察,因(yīn)此認證過程複雜且耗時較長。液冷數據中心(xīn)基礎設施廠商應具(jù)備較強的產品研發能力、穩定的產品供應以及(jí)售(shòu)後(hòu)服務經驗,同時具備豐富的技術(shù)儲備,才能滿足不同客戶的需求。另一方麵,由於更換液冷數據中心基礎設施(shī)供應商(shāng)會對產(chǎn)品的穩定性形成(chéng)風險,客戶在與液冷數據中心基礎(chǔ)設施供應商建立生產配套關係後,傾向於維持與現有技術供應商的合作,不(bú)會輕易更換主要供應商,因此先進入者一旦建立起自(zì)身客戶資源、形成先發優勢,新進入企業將很難在短期內爭奪市場份額、改變行業現有格(gé)局,因此數據中心液冷行業具有較高的客戶認(rèn)證門檻。

2.3 競爭格局:行業仍處於技術驗(yàn)證階(jiē)段,市場格局尚不明確

目前液冷行業仍處於技術驗證階段,技術(shù)路線、產品結構、行業標準等還無定數,國外(wài)廠商難以進(jìn)入中國市場,市場競爭格局(jú)尚(shàng)不明確。目(mù)前市場中主要廠商在液(yè)冷技術(shù)和產品方麵還處於實驗研究(jiū)或初步應用階段,產品(pǐn)結構與行業標準尚在演進(jìn),市(shì)場內(nèi)還未形(xíng)成具備較強核心(xīn)競爭力的龍頭廠商,市場競爭(zhēng)格局尚(shàng)未穩定。此外(wài),由於中國對(duì)數據安全的保護,在數據中心基礎設施的供應方麵存在一定的地域壁(bì)壘(lěi),因此(cǐ),目前國外廠商的產品的應用主要以其本國市場為主,進入中國市場較為困難。

3 數據中心液冷(lěng)行業未來看點

3.1 推理/訓練服務器功耗有望達到10/2kW,液冷方案成為首選

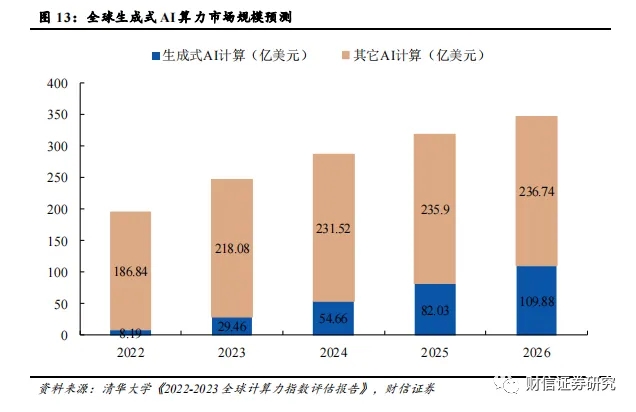

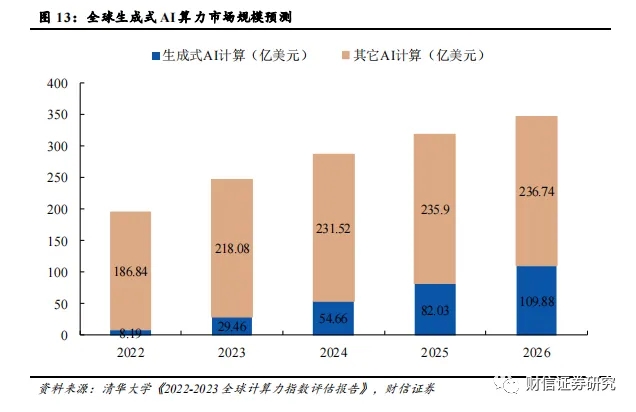

生成式人工智能橫(héng)空出世,助推AI算力(lì)景氣度。受ChatGPT為代表的生成式(shì)人工智能大模型等新業態(tài)帶動,全新的AI應用場景有望在未來3-5年(nián)爆發,百(bǎi)億參數是大模型(xíng)具備湧現能(néng)力的門(mén)檻,千億參數的大(dà)模型將具備較(jiào)好的湧現(xiàn)能(néng)力,AI算力成為大模型能力提升的核心(xīn)驅動力。現階段ChatGPT的總算力消(xiāo)耗(hào)達到(dào)了3640PF-day(每秒計算(suàn)一千萬億次,需要計算3640天),需要7-8個投資規模30億元,算(suàn)力500P的超(chāo)大數據中心才能(néng)支(zhī)撐(chēng)其訓練過程,AI算力的重要性不言(yán)而喻。據IDC預測,全球AI算力市場(chǎng)規(guī)模將(jiāng)從2022年的195.0億美元增長到2026年的346.6億美元,其中生成式AI算力市場規模將從2022年的8.2億美元增長到2026年的109.9億(yì)美(měi)元,生成式AI算力占(zhàn)整體AI算(suàn)力(lì)市場規模的比例將從4.2%增長到31.7%。

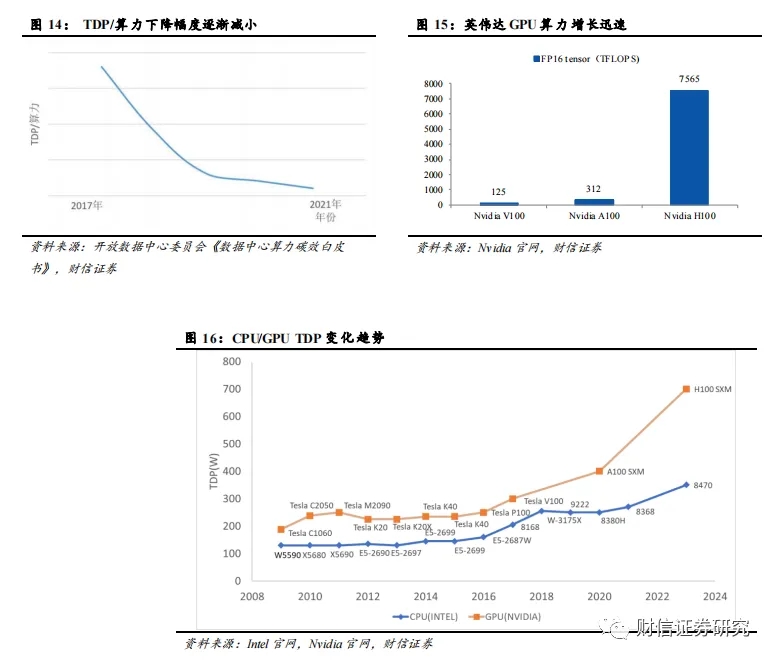

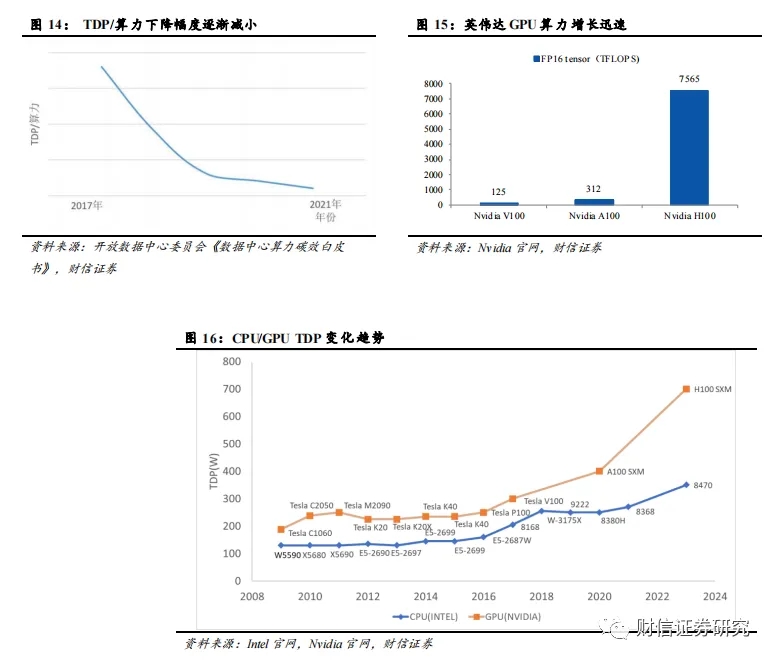

大模型帶來高算力,高(gāo)算力(lì)帶來高功耗。隨著AI計算、HPC計算等(děng)高性能計算需求不斷提(tí)升,CPU、GPU等計算芯片朝高算力、高(gāo)集(jí)成方向演進,同時也導(dǎo)致單顆計算芯片功耗的大幅提(tí)升。對於CPU、GPU、ASIC等計算芯片而(ér)言,一方麵可以通過(guò)增加計算核心數或提高單核心(xīn)的主頻等方式來提(tí)高算力,此舉會顯著增加芯片的TDP(熱設計功耗);另一方麵可以依靠(kào)先進製程技術來縮減單位算(suàn)力對應的TDP(TDP/算力)。但是由於先進製程技術(shù)推進較慢等因素,單位算力(lì)對應TDP的下降幅度逐(zhú)年減少,且遠不(bú)及算力的增長速度,這也導致了AI芯片功耗(hào)的大(dà)幅攀升。當前,Intel的多(duō)款CPU芯片(piàn)的(de)TDP已突破350W,NVIDIA 的H100係列GPU芯片的TDP更高達700W。

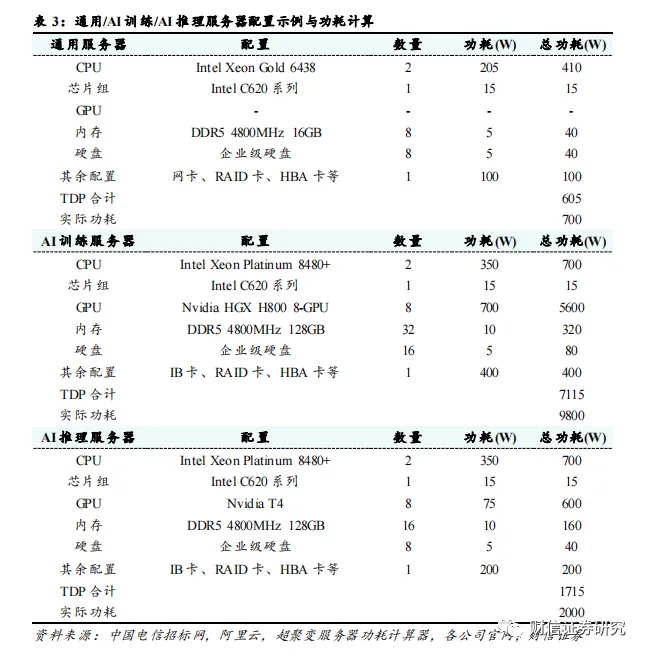

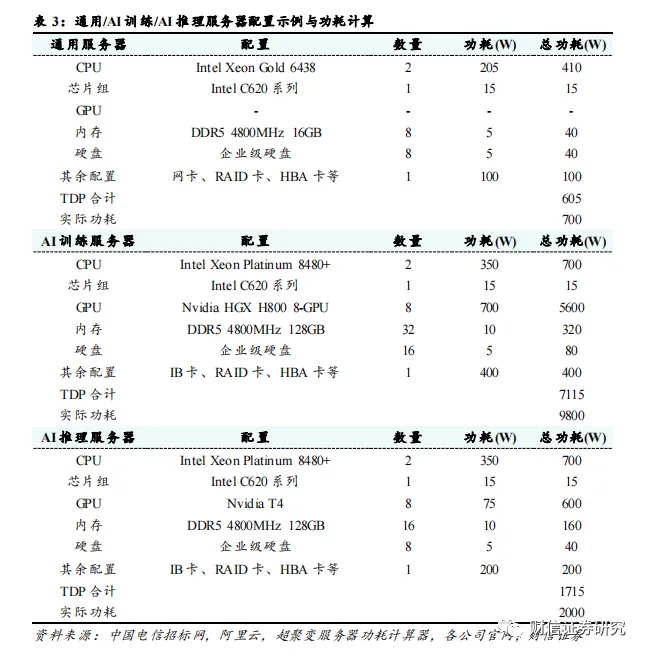

計算芯片高功耗造成單服務器功耗(hào)顯著提高。單服務器(qì)功耗大部分源於計算(suàn)芯片,服務器的核心組件包括CPU(中央處理器)、GPU(圖形處理器)、內存芯片、SSD(固態硬盤(pán))、網卡、PCB主板、RAID卡、HBA卡和電源(yuán)等。CPU/GPU等計算芯片在通用服務器功耗中占比約為50%左右,而在AI服務器(qì)中,計算(suàn)芯片的功耗占比高達80%以上。我們參考2022-2023年(nián)中國電信集(jí)采AI服務器配置與阿裏雲通用服務器配置進行功耗計算,服務器的功耗可以粗略估計為所有組件的功耗總和;選取超聚變FusionServer 2288 V7作為通用服務器的(de)代表型號(hào),超聚變(biàn)FusionServer G5500 V6作為AI訓練服務器(qì)的代表型號(hào),超聚變FusionServer G8600 V7作為AI推理服(fú)務器的代表型號。

通(tōng)過我們的測算,通用服務器的總功耗為595W,AI訓練服務器的(de)總功耗為7015W,AI推(tuī)理(lǐ)服(fú)務器的總功耗為1615W。但(dàn)是由於芯片超頻,額外的NVLINK模組等因素的存在,計算芯(xīn)片的實際滿載(zǎi)功耗往往會高於官方(fāng)標(biāo)定的功耗。以上因素導致(zhì)服務器的實(shí)際(jì)功耗可能會高於各組件的總功耗,具體的(de)功耗還要(yào)以實際測試為準。根據超聚變服務器功耗計算器的測算,當前配置下的通用服務器的實(shí)際滿載功耗為700W左右,AI訓練服務器(qì)的實(shí)際滿載功耗為9800W左右,AI推理(lǐ)服務器(qì)的實際滿載功耗為(wéi)2000W左(zuǒ)右。(該過程(chéng)僅為根據公開資料的估算,請以實際(jì)環境和負載下(xià)的測算為準)

隨著服(fú)務器功耗提高,單機櫃功(gōng)率上升趨勢(shì)明顯。根據Uptime Institute相關報告數據顯示,2020年全球數(shù)據中心單(dān)機櫃功率密度達到8.4kW/機櫃,相比於(yú)2017年的5.6 kW/機櫃有明(míng)顯提升;其中71%的數據中心平均功率密度低於10 kW/機櫃(guì),17%的數據中心平均功率密度高於20kW/機櫃,預計未來數據中心功率密度將繼續上升,高密(mì)度數據中心(xīn)占比將(jiāng)持續提高。

單機櫃功率(lǜ)逐漸超出風冷(lěng)散熱閾值,液(yè)冷散熱已是趨勢所(suǒ)向。風冷散熱一般適用於20Kw/機櫃左右的功率密度以下,20Kw/機櫃以上時液冷散熱優勢(shì)明顯。通用服務器通常為2U,AI訓練服務器通常為6U,AI推(tuī)理服務器通常(cháng)為(wéi)4U,標準機櫃為42U;考慮到電源模塊、網絡模塊等因素,假設單機櫃內(nèi)可以放置18個通用服務器或6個AI訓(xùn)練服務器或9個AI推理服務(wù)器,根據之前對於(yú)服務器功耗的測算,則單(dān)機櫃功率可以分別達到12.6kW(通用),58.8kW(AI訓練)和(hé)18kW(AI推理);考慮(lǜ)到機櫃(guì)中其他模塊的散熱情況,實際單機櫃功率(lǜ)會更高。對於通用服務器機櫃,其單機櫃功率已經開始逐(zhú)步(bù)靠近風冷散熱閾值,隨著通用服務器功耗的持(chí)續上(shàng)升,液冷散熱的優勢有望逐步顯現;對於AI訓練與推(tuī)理服務器機櫃,其單機櫃(guì)功率(lǜ)已經逼近或者超出了風冷散熱所能覆蓋的功率密度範圍,液冷散熱已成大勢所趨。

3.2 PUE限製是現階段液冷(lěng)技(jì)術(shù)發展的核心驅動力

數據中心耗(hào)電量不斷提升,綠色(sè)低碳成為必然趨勢。數據中心是能耗大戶,其包含大量的(de) IT 設備、供電與製冷設備(bèi)。隨著數據中心算力與功耗的不斷增長,數據中心耗電量必將呈快速(sù)增(zēng)長趨勢,綠色(sè)低碳必將並且已經成為(wéi)新型數據中心發展的重(chóng)要基本原則之一(yī)。

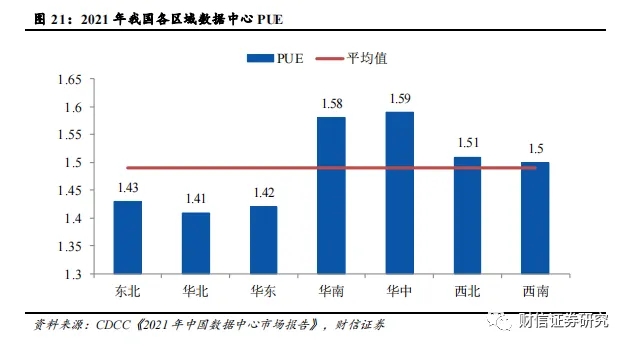

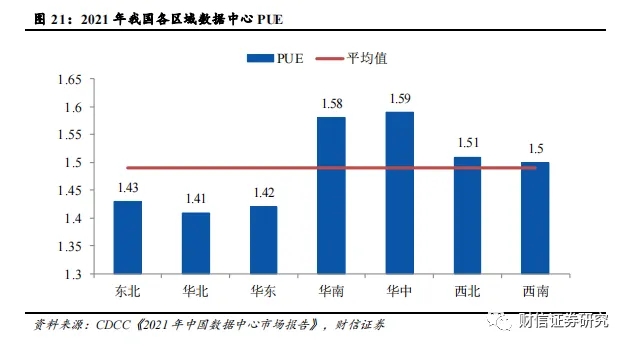

我國數(shù)據(jù)中心平均PUE為1.49,仍有半數區域的數據中心PUE位於1.5以上。PUE 全稱 “Power Usage Effectiveness(能源使用效率)”,是數據中心(xīn)消(xiāo)耗的一切能源與 IT 負載運用的能源之比,比值越接近於1,說(shuō)明能源越接近全部都用於 IT 負載上。目前我國一半以上區域的數據中心 PUE 值都在 1.5 以上,即消耗在(zài)冷卻等非 IT 負載上的(de)能源(yuán),占到了 IT 負載的一(yī)半以上。截至2021年全國數據中心平均PUE為(wéi)1.49,還有華南、華(huá)東、西北和西南區域(yù)的數據中心PUE超過1.50,僅有東北(běi)、華北和華東區域的數據中心PUE在1.50以下。

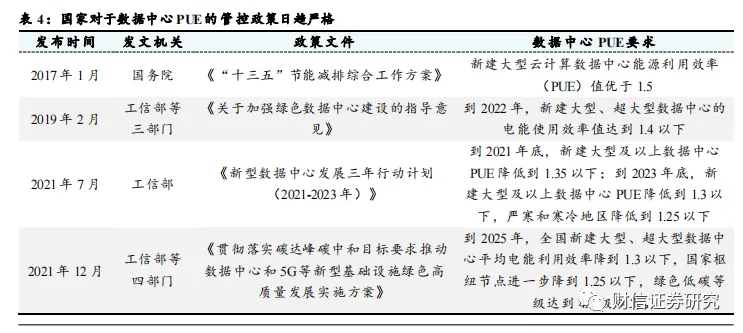

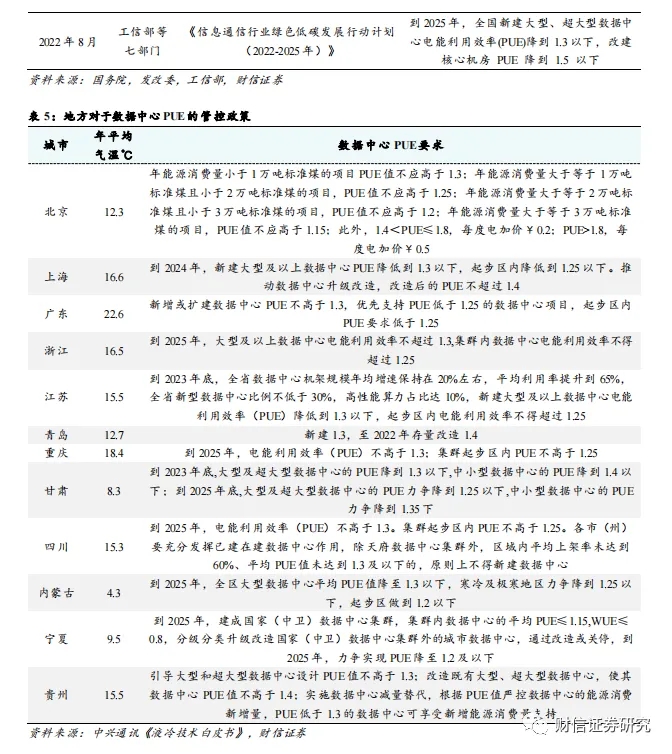

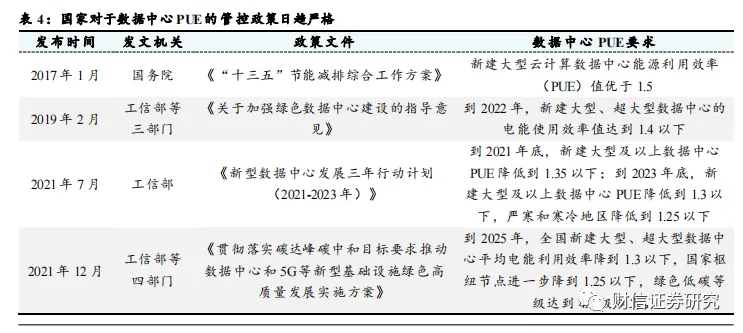

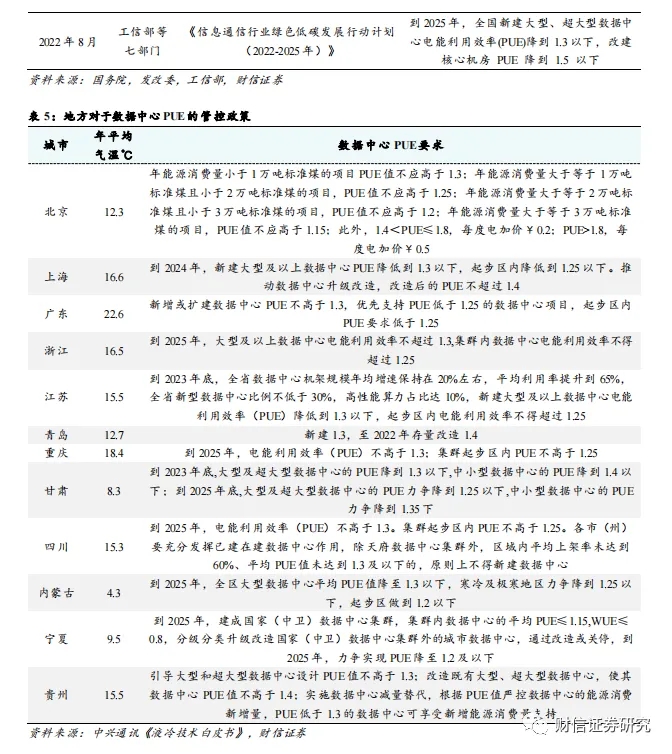

數據中心PUE管控日趨嚴格(gé),針對老舊與新建數據中心均出台強力約束措施。國家與地方出台了一係列政策(cè)對數據中心能耗管(guǎn)理進行(háng)規範,不斷強調數據中(zhōng)心綠色(sè)高質量發展(zhǎn)的(de)重要性。2021年7月,工信部印(yìn)發《新型數據(jù)中心(xīn)發展三(sān)年行動計劃(2021-2023年)》,要求到2021年底,新建(jiàn)大型及以上數據中心PUE降低到1.35以下;到2023年底,新建大型及以上數據中心PUE降低到(dào)1.3以下,嚴寒和寒冷地區降低到1.25以下。2022年(nián)8月,工信部等七部門印發《信息通信(xìn)行業綠色低碳發展行(háng)動計劃(huá)(2022-2025年)》,要求到2025年,全國新建大型、超大型數據中心電能利用效率(PUE)降到(dào)1.3以下,改建(jiàn)核心機房(fáng)PUE降(jiàng)到1.5以下(xià)。除此之外(wài),地方也出台(tái)了一係列數據中心PUE要求相關(guān)的政策文(wén)件,其中(zhōng)北京針(zhēn)對(duì)數據中心的年能源消耗量(liàng)設立了多層次PUE要求,年能源消耗量越高的數據中心PUE要求越高,此外還針對PUE超過1.4的數據中心實(shí)行電價加價措施。

冷卻係統占據數據中心除IT設備負載(zǎi)外的能耗中的絕大部分,液冷技術能夠有(yǒu)效降低冷卻係(xì)統能耗(hào),進而降低數據中心PUE,滿足監管政策要求。PUE為1.92的(de)數據中心下冷卻係統能耗占總能耗的比例為38%左右,而PUE為1.3的數據中心下冷卻係統能耗占比下降至18%,這意味(wèi)著降低數(shù)據中心PUE的關鍵就在於降(jiàng)低冷卻係統的能耗表現(xiàn)。在同等的散熱水平下,傳統風冷(lěng)方案的數據中心PUE一(yī)般為1.5左右,液冷方案的PUE值可降至1.05-1.2左右,能夠(gòu)滿足當前政策對於數據(jù)中心PUE的要求。

3.3 數據中心TCO是液冷技術規模應用的關鍵(jiàn)因素

數據中心總成本(TCO)包括建設成本(Capex)和運營成本(Opex)。Capex一般指建設成本,包(bāo)括(kuò)土地獲取、勘察、規劃設計、設備購置、建設、安裝(zhuāng)以及係統調測等費用;Opex一般指運營成本,主要包含電力、冷卻散(sàn)熱等(děng)基礎設施成本、維護成本及管理成本。低成本是(shì)數據中心建立競爭優勢的關鍵,也是降低投資回收期和持續發展的關鍵。

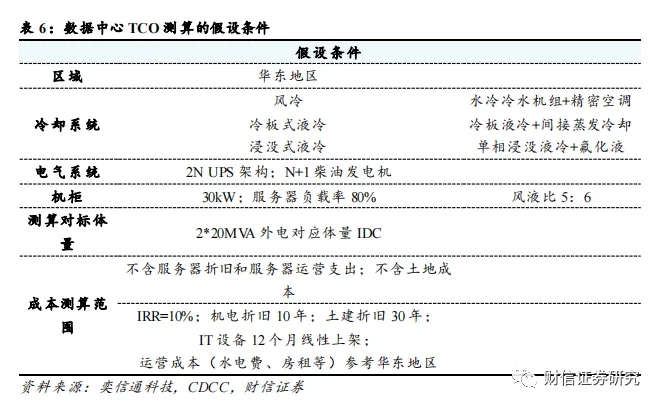

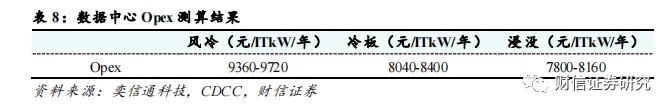

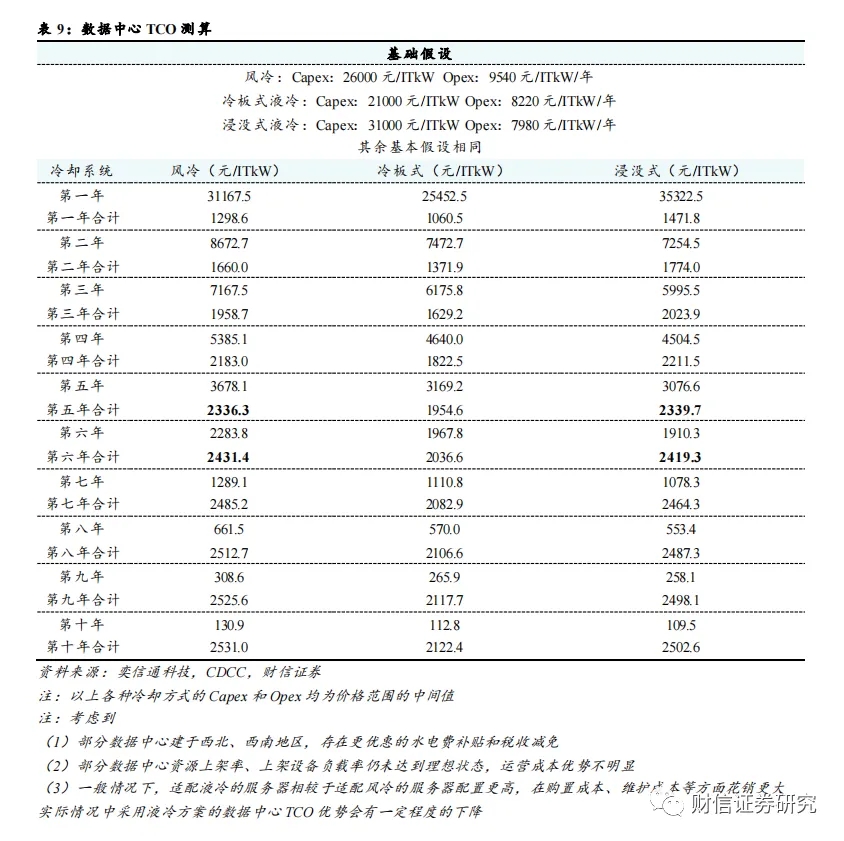

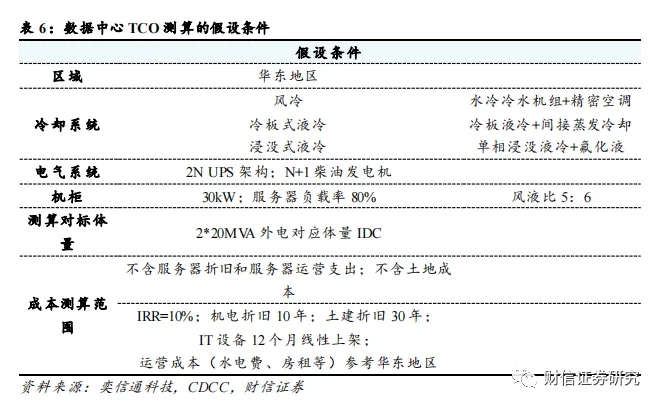

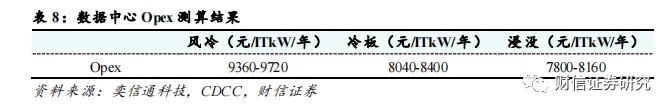

我們基於華(huá)東地區、2N UPS、30kW每機(jī)櫃等常見數據中心配置進(jìn)行風冷、冷板式液冷和浸沒式液冷等不同冷卻(què)方式下的TCO測算(本文關於TCO的討論均不考慮服務(wù)器等IT設備成本)。市場普遍認為,風冷方案在Capex上更具經濟性(xìng),液(yè)冷方案隻在後續的(de)Opex中有一(yī)定的優勢。但是根據奕信通科技在2022年數據中心(xīn)標準峰會(CDCC)發布的報告進行測算,現階段(duàn)選擇冷板式液冷方案的Capex已經低於風冷方案,即便是浸沒式液冷方案,也(yě)將在運行5年左(zuǒ)右之後出現TCO低於風冷方案(àn)的拐點。(該過程僅為根據公開資料的估算,請以實際環境和負載下的測算為準)

但是(shì)該測算結果依賴於一定的前提條件:如機櫃功率達(dá)到30KW、不計算服務(wù)器折舊和服務器運營(yíng)支出、水電費與(yǔ)房(fáng)租等運營成本按華(huá)東地區情況計(jì)價、采用集中式大型IDC機房且IT設備在12個月線(xiàn)性上架後實現80%負載率(lǜ)、外界氣溫對製冷係統(tǒng)的能耗需(xū)求較高等(děng)。因此在西北(běi)部地區、較小型數據(jù)中心等場景下液冷技術的經濟性尚沒(méi)有完全體現。但在數據中心發展的大型化、集約化的(de)趨勢下(xià),且液冷方案仍存在每年降本5-10%的空間,再考慮到(dào)液冷方案(àn)能夠有效延長服務器使用壽命,未來液冷數(shù)據中(zhōng)心TCO的優勢將(jiāng)更加明顯。

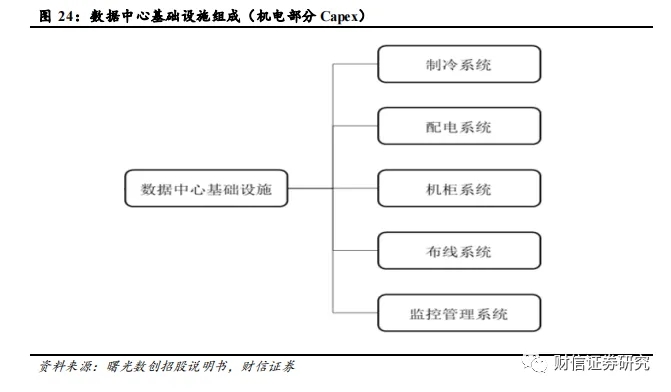

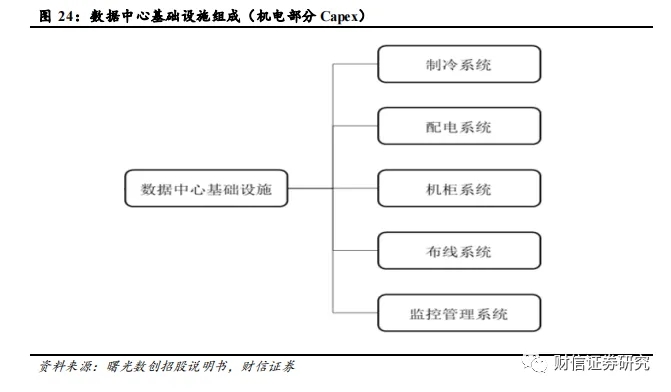

機電部分(fèn)包括製冷(lěng)係統、配(pèi)電係統、機櫃係統、布線係統(tǒng)和監控管理係(xì)統的購置和(hé)安裝成本,不考慮IT設備成本。

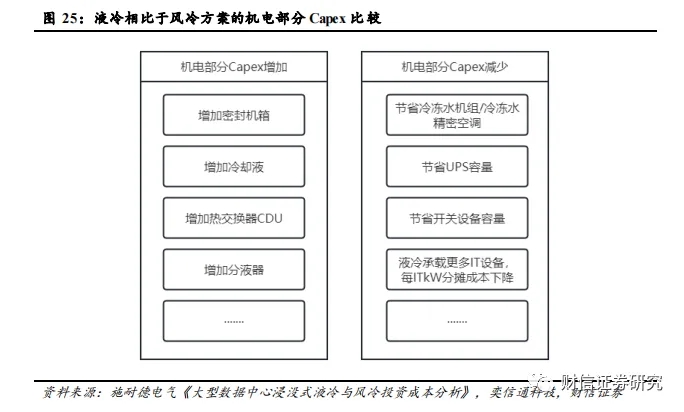

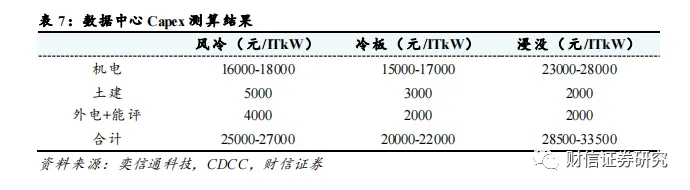

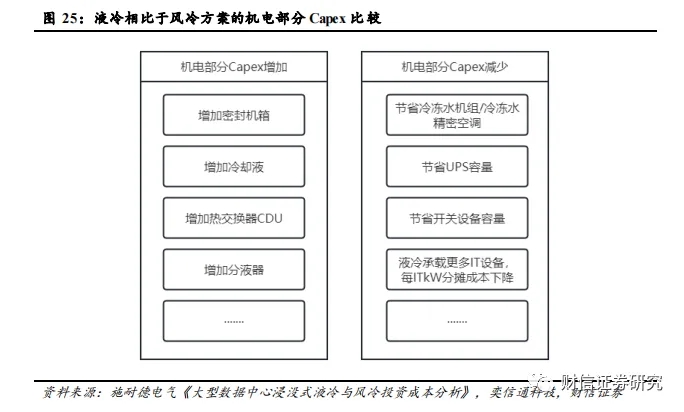

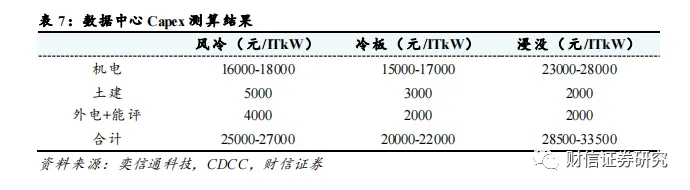

液冷方案與風(fēng)冷方案相比:1)其機(jī)電部分的Capex可以節省掉(diào)冷凍水機組/冷凍水精密空調,減少UPS和開關設備的容量等;2)需要(yào)增加密封(fēng)機箱、冷卻液(yè)、冷板、熱(rè)交換器、防滴漏連接器和機架式分液器等液冷設備方麵的成本;3)液冷(lěng)方案下同樣外電體(tǐ)量的數據中心內空間利用率更高,能承載更多IT設備,每ITkW(IT設備功率)下的分攤成本更低。根據假設(shè)條件測算,風冷(lěng)、冷板式液冷、浸沒式液(yè)冷方(fāng)案的(de)機電部(bù)分Capex分別為(wéi)16000-18000元/ITkW、15000-17000元(yuán)/ITkW和(hé)23000-28000元/ITkW左右。冷板式液冷方案下分攤(tān)到每ITkW下的機電(diàn)部分Capex與風冷方(fāng)案基本(běn)持平甚至更低;浸沒式液冷方案所需增加的(de)機電設備(bèi)較多,分(fèn)攤下來每ITkW的(de)Capex相比於風冷仍有7000-10000元/ITkW左右的上升。

土建部分主要包括建(jiàn)築物成本。風(fēng)冷和(hé)液冷方案的土建成本差異主要在於(yú)同樣體量的數據中心內,液冷方案下建築所需的建築麵積更小。根據奕信通科技測算,風冷(lěng)、冷板式液冷、浸沒式液(yè)冷的土建部分Capex分別為5000元/ITkW,3000元/ITkW和3500元(yuán)/ITkW左右。

外電和能評(píng)部分主要包(bāo)括(kuò)獲取外(wài)電資源,通(tōng)過能評驗收所需(xū)付出(chū)的成本。與風冷相比,液冷方案的(de)PUE更(gèng)低更節能,獲取外電資源,通過能評驗收的難度相對會小很多(duō)。根據奕信通(tōng)科技測算,風冷、冷板式液冷、浸沒式液冷的(de)外電和能評部分Capex分(fèn)別為4000元/ITkW,2000元/ITkW和2000元/ITkW左右。

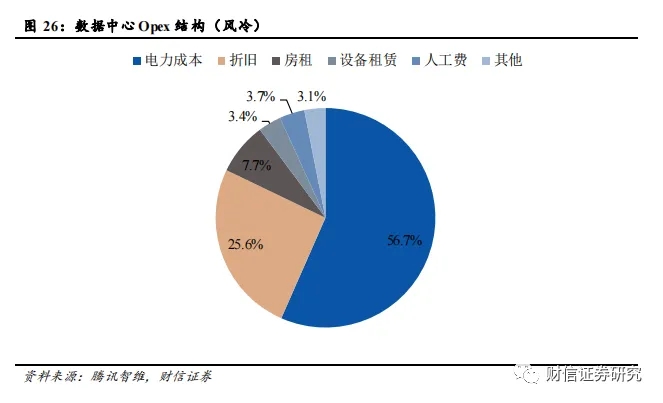

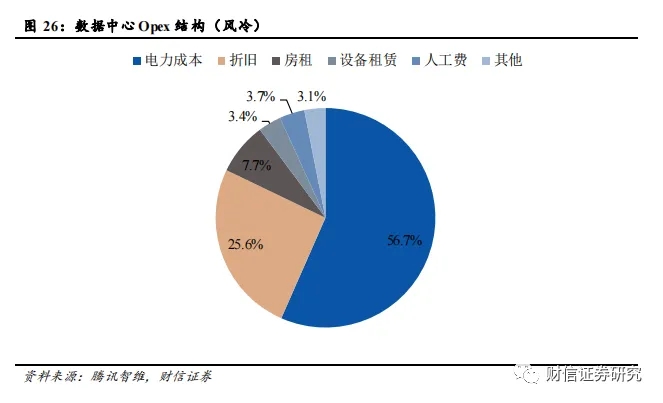

Opex中占比*高的是(shì)電力成本,液冷技術可以有效降低電力成本。數據(jù)中心的Opex主(zhǔ)要包括電力成本、固定資產折舊、房租、人工費等等,其中電力成本占比*高,達到56.7%(風冷情況下)。

浸沒式液冷方案的Opex*具優勢。根(gēn)據(jù)奕信通科技測算,風冷方案的Opex為(wéi)9360-9720元/ITkw/年(nián)左右,冷板式液冷方案的Opex為8040-8400元/ITkw/年左右,浸沒(méi)式液冷方案的Opex是7800-8160元/ITkw/年左右。

現階段選擇冷板式液冷的初始(shǐ)TCO已經低於風(fēng)冷,浸沒式液冷(lěng)的TCO將在5-6年之後低(dī)於風冷。我們根據以上測算結果進行10年期的TCO測算,那麽風冷(lěng)的Capex和(hé)Opex分別為26000元/ITkW和9540元/ITkW/年,冷板式液冷的Capex和Opex分別為21000元/ITkW和8220元/ITkW/年,浸沒式液冷的Capex和Opex分別為31000元/ITkW和7980元/ITkW/年。根據TCO測算,現階段冷板式液冷(lěng)方案(àn)的TCO從(cóng)開始就已經低於風(fēng)冷(lěng)方案,浸沒式液(yè)冷方案也將在5年左右之後出現TCO低於風冷方案的拐點。

3.4 液冷技術能夠有(yǒu)效延長服務器使用壽命,實現降本(běn)增效

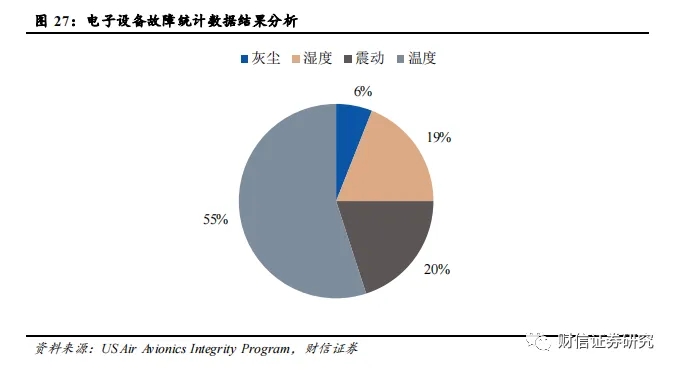

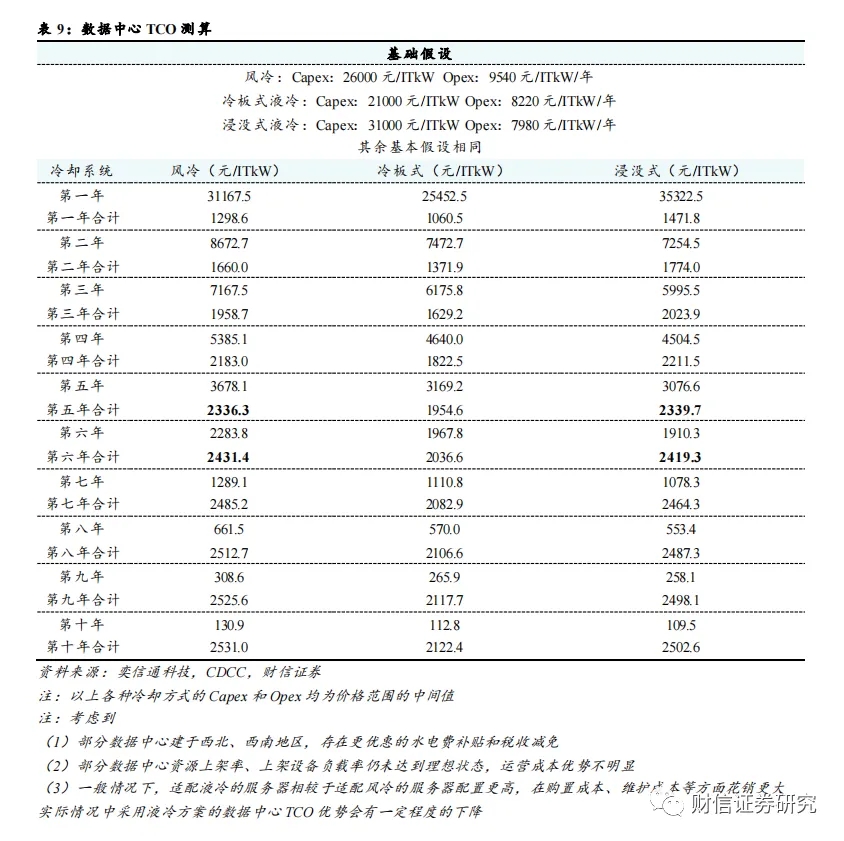

傳統(tǒng)電子設備普遍采用空氣冷卻方式,溫度是電子設備產生故障的(de)主要原因之一。環境的多樣性包括溫度、濕度、振動(dòng)、灰塵等多個方麵,在導致電子設備失效的因素中溫度占了55%,過(guò)熱是(shì)電子設(shè)備產(chǎn)生故障的主要誘因。隨著溫度的增加,電(diàn)子、原子、分(fèn)子的運動速度加快(kuài),使得電子設備(bèi)的性能發生變化,當達到一定階段時,就會引起嚴重的故障。在高(gāo)於(yú)一般室內環境溫度(約(yuē)20°C~25°C)範圍內條件(jiàn)下,故障率大致按指數規律隨溫度(dù)的升高而增加。同時,濕(shī)度、振動、灰塵等因素同樣會對電(diàn)子設備的工作性能和使用壽命產生負麵影響。

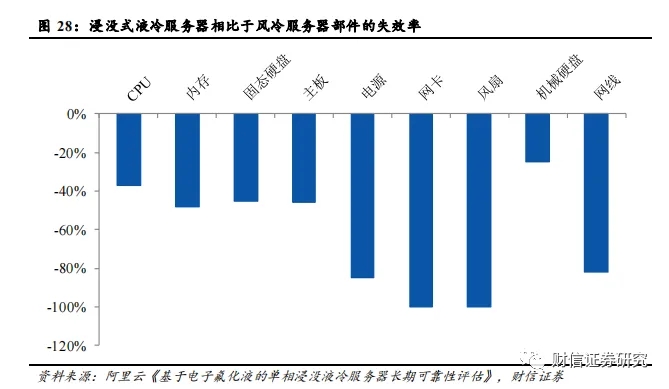

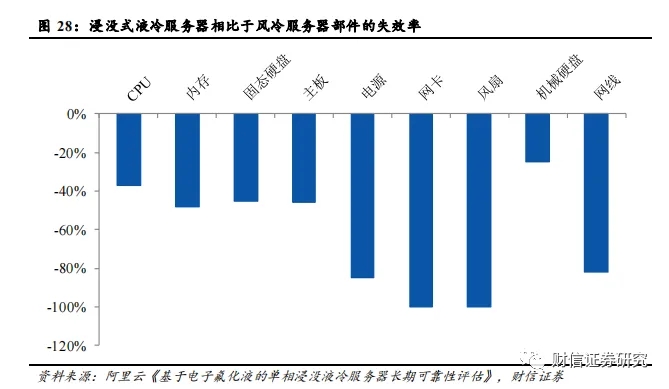

液冷能夠有效降低服務器(qì)部件(jiàn)故障率,延長使用壽命。液體具有比空氣更大的比(bǐ)熱容,散熱能力更強,使得服務器溫度更加穩定,CPU和GPU計算部件(jiàn)可以長時間穩定工作在高性能頻率狀態。此外,浸沒式液(yè)冷將IT設備浸(jìn)入封閉的液體環境中,與空(kōng)氣完全隔離,並且不再需(xū)要高速風扇進(jìn)行散熱,消除了空氣濕(shī)度、風扇振動以及灰塵帶來的可靠性影(yǐng)響,從而優化了服務器的運(yùn)行環境,延長了設備的(de)使(shǐ)用壽命。根據阿裏雲的實驗數據,與風冷服務器相比,液冷服務器整體部件故(gù)障率下降約53%,其中電(diàn)源、網卡、風扇、網線等部件的故障率下降超過80%。隨著單服務器價值量(liàng)以及數據中(zhōng)心運營成本的與日俱增(zēng),服務器的可靠(kào)性與使用(yòng)壽命顯(xiǎn)得尤為重要,液冷帶來的附加經濟價值有望逐步顯現。

3.5 解(jiě)耦交付模式成為未來發展趨勢,助力液冷(lěng)產業規範化發展

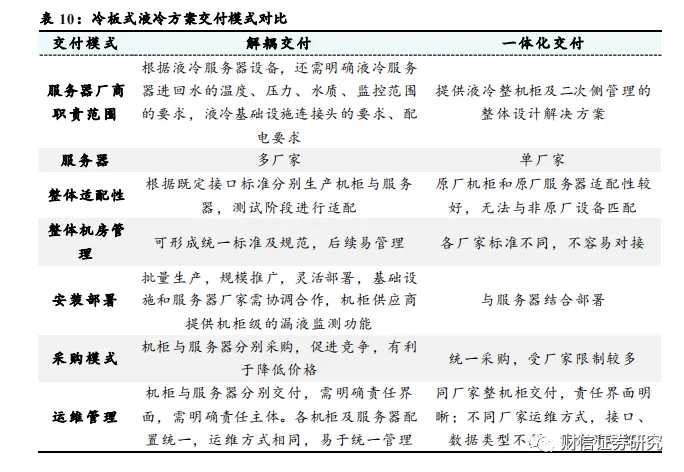

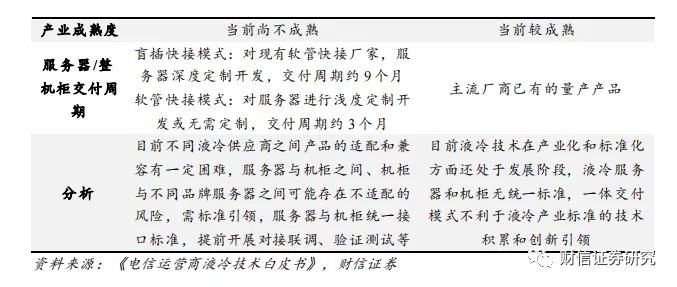

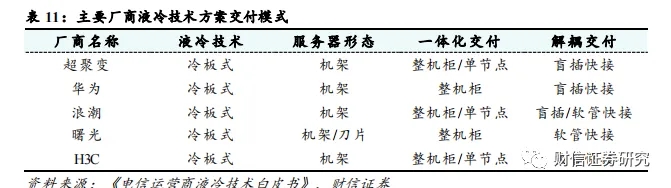

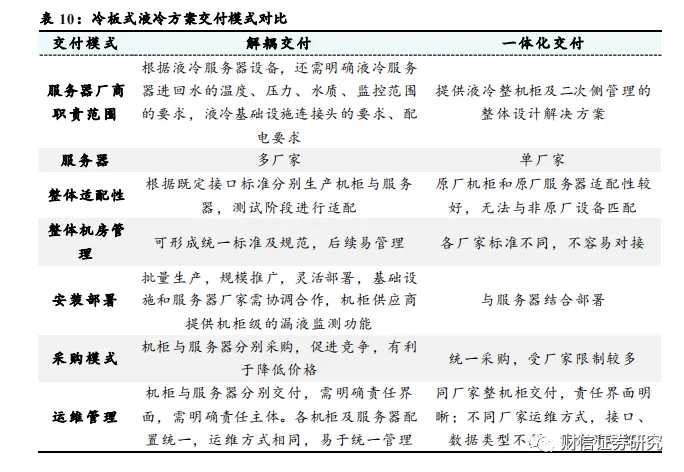

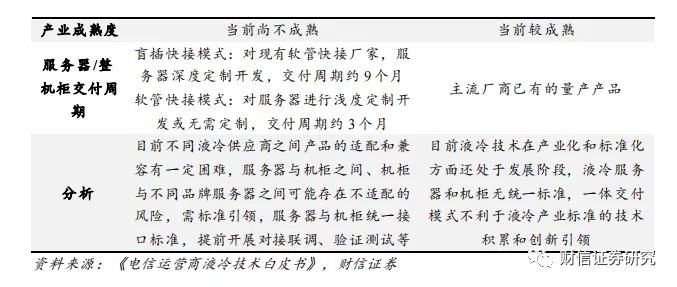

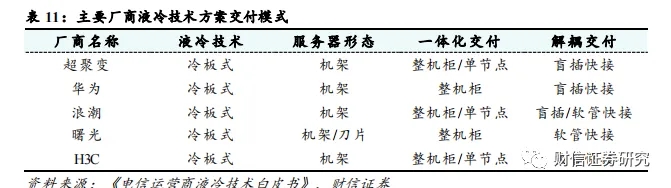

目前冷板式液冷方案的交付模式可以分為(wéi)兩類,包括一體化交付與解耦交付兩種。一體化交付是指液冷機櫃的所有部分,包括機(jī)櫃和服務器等,都按(àn)照(zhào)廠商自行設定的標準進(jìn)行集成設計(jì)開發,然後再作為一個(gè)整體進行交付。而(ér)解耦交付則要求液冷(lěng)機櫃與液冷服務器之間遵循用戶預先製定的通用接口設計規範,機櫃與服務器可(kě)以分別由不同(tóng)廠商負責生產和交付。

解耦交付(fù)模式為大勢所趨(qū),助推冷板式液冷產業規範化發(fā)展。服務(wù)器與機櫃解耦更有利於形成統一(yī)的技(jì)術標準及規範,能夠促進行業競(jìng)爭(zhēng)與技術推廣,讓更多廠商能夠參與液冷行業,實現多(duō)廠(chǎng)家適配,也便於後續靈活部署,使得客戶可以根據實際需求選擇不同的服務器和機櫃組合,不(bú)會受限於某一個供(gòng)應商。目前(qián)華為、超(chāo)聚變等液(yè)冷廠商已(yǐ)經實現了盲插快接,中國移動也已經著手研發新型機櫃,並計劃在完(wán)成測(cè)試後(hòu)開源,推動更(gèng)多的服務器和機櫃廠商參與到盲插解耦液(yè)冷技術的研發與驗證中,推動技術成熟(shú)與規範化(huà)。

4 數據中心液冷未來市場規模估算

根據估算,到(dào)2025年,中國數據中心液冷市場規模將達到359億元左右,CAGR達到72.4%;AI數據中心液冷市場(chǎng)規模將達到280億元(yuán)左(zuǒ)右,CAGR達到71.4%;通用數據中(zhōng)心液冷市場規模將達到79億元,CAGR達到76.2%。核心假(jiǎ)設如下:

1)假(jiǎ)設通用服務器(qì)的平均功率為0.7kW。以超聚變FusionServer 2288 V7(2U)作為通(tōng)用服務器(qì)的代表型號(hào),在超聚變服務器(qì)功耗計(jì)算器中(zhōng)測算得(dé)出其滿載功率約為0.7kW。

2)假設AI服務器的平均功率為3.8kW,其中AI訓練服務器平均功率為8kW,AI推理服(fú)務器為2kW。根據產業調研數據,假設AI服務器中訓練與推理(lǐ)的數量關係約為3:7,訓練服務器(qì)中H係列和A係列所占比例約為4:6,推理服務器均為T4係列。以超聚變FusionServer G5500 V6作為AI訓練服務器的代(dài)表型號,超聚變FusionServer G8600 V7作(zuò)為AI推理服務器的(de)代表型號,根據超聚變服(fú)務器功耗計算器,H係列訓練服務器滿載(zǎi)功(gōng)率約為10kW,A係列(liè)訓(xùn)練(liàn)服務器滿載功率約為6.8kW,T4係列推理服務器的功率約為2KW。結合以上數量比例關係(xì),可以估算出AI服務器(qì)平均功率約為3.8kW。

3)假設通用服務(wù)器平(píng)均功率每年提升10%,AI訓練與推理(lǐ)服務(wù)器平均(jun1)功率未來三年提升30%/20%/15%。根據近幾年CPU/GPU TDP的變化趨勢(shì),CPU TDP每年提升10%左右,GPU TDP每年提升(shēng)20%左右,我們假設通用服務器平均功率(lǜ)未(wèi)來三年保持10%左右的增速,AI訓練與推理服(fú)務器平均(jun1)功率未來三(sān)年的增速為(wéi)30%/20%/15%。

4)至2025年,假設通用服務器液(yè)冷滲透率由5%提升到20%,AI訓練服務器(qì)液冷滲透率由70%提升(shēng)到100%,AI推理服務器液冷滲透率由40%提升至70%。根據產業調研與曙光數創的信息,2022年我國液冷滲透率為5%-8%左右(yòu),預(yù)計2025-2028年時液冷滲透率能(néng)達到30%左右。我們假設通(tōng)用(yòng)服務器2022年液冷滲透率為5%,至2025年液冷滲透率上升至20%;AI訓練服務器2022年液(yè)冷滲(shèn)透率為70%,至2025年液冷滲透率上升至100%;AI推理服務器2022年液(yè)冷滲透率為40%,至2025年液冷滲透率上升至70%;整體液冷(lěng)滲透(tòu)率(lǜ)由2022年的8%上升至(zhì)2025年的25.7%。

5)至2025年,假設浸沒式液冷滲透率由10%提升至30%,冷板式液冷滲透率由90%降低至(zhì)70%。根據IDC《中國半年度液冷服務器市場(2023上半年)跟蹤》報告,按(àn)照(zhào)服務器出貨量口(kǒu)徑統計,2023H1我國冷板(bǎn)式液冷服務器比(bǐ)例為90%左右,浸沒式液冷滲透率(lǜ)僅為10%。隨著未來(lái)浸沒式液冷技術逐漸成熟進入加速推廣期,我們預計浸沒式(shì)液冷的滲透率由2022年的10%上升至2025年的(de)30%,冷板式液冷的滲(shèn)透率(lǜ)由2022年的90%下降至70%。

6)考(kǎo)慮到大部分數據中心(xīn)液冷廠商的產品隻覆蓋數據中(zhōng)心液冷基礎設施中的(de)製冷係(xì)統、機櫃係統等(děng)核心部分,故估算數據中心液冷市場規模時隻考慮數據中心液冷基礎設施中製冷係統、機櫃係統等核心部分的市場規模,不考慮(lǜ)布線係統、土建、外電、能評等其他配套部分。結合產業調研數據,假設冷板式液冷基礎設施的價值量約為10000元/ITkW,浸沒式液冷基礎設施的價值量約(yuē)為15000元/ITkW。

7)考慮到未來數(shù)據中心液冷市場競爭(zhēng)逐步加劇以(yǐ)及技術逐漸成熟,液冷方(fāng)案價(jià)格將(jiāng)呈逐年下降的趨勢(shì);冷板式液(yè)冷技術目前更(gèng)為成(chéng)熟,未來價格的下降空間相對較小。我們假設冷板式液冷價值量逐年下降5%,浸沒式液冷價值量逐年下降10%。

以下(xià)是A股(gǔ)液冷服務器概念梳理:

中科(kē)曙光(guāng):公司(sī)的 ParaStor 液冷存儲產品將液冷方案與存(cún)儲技(jì)術結合, 有效降低 PUE 值(zhí);在應用層麵,靈(líng)活(huó)配置多種場(chǎng)景, 針對高性能小規模應(yīng)用(yòng)場(chǎng)景,提供全閃存配置方案,而針對中(zhōng)大規模應用場景,則提供(gòng)更高性價比的(de)混閃配置方案,為客戶(hù)釋放更多(duō)的業務價值。此外,ParaStor 液冷存儲(chǔ)產品與液冷服務器形(xíng)成“存算一(yī)棧式” 液冷方案,在提高運維效率的同時,助力數據中心部署更便捷。(行業龍(lóng)頭)

浪潮信息:浪潮信息將“All in 液冷(lěng)”納入公司發展戰略(luè),全棧(zhàn)布局液冷,發布全棧液冷產品(pǐn),實現通用服務器、高密(mì)度服務器、整機櫃(guì)服務器(qì)、AI 服務器四大係列(liè)全線產品均支持冷板式液冷,並提供液冷數據(jù)中心全生命周期整體解決方案(行業龍頭)

工業富聯:公司研發基於開放平台(tái)聯盟架構的 DC_MHS 數據中心模塊化硬件係統(tǒng),推出全球**台模塊化服務器,同時產品應用於客戶*新一代(dài) HPC 加速器中;液冷技術方麵,公司持續加大數據中心節能技術研(yán)發,通過沉浸式與機櫃式液冷散熱係統,實現成本節約及效率提升。(行業龍頭)

紫光股份:2022年公司發布了H3C UniServer R4900LC G5液冷服務器及以其為核心的液冷係統、新一代超(chāo)融合UIS8.0、全新綠洲平台2.0等產品和(hé)方案。(行業龍頭)

中興通訊:公司擁有全係(xì)列服務器及存儲產品,包括通用服務器、GPU服(fú)務器、液冷服務器以及全閃存儲產品、混閃存儲產品等。(行業龍頭)

光迅科技(jì):公司是浸沒液冷智算產業發展聯盟會員單位,是相關標準、工藝研(yán)究和實踐的重要參與者之一,目前已有相(xiàng)關產品發布。(行業新(xīn)玩家)

飛龍股份:公司(sī)的數據中心(xīn)液(yè)冷產品在(zài)蕪湖飛龍(lóng)、鄭州飛龍已建有專門生(shēng)產線。公司多個液冷項目正在進行中,部分項目已經量產。(行(háng)業新玩家)

網宿(xiǔ)科技:公司全資子公(gōng)司綠色雲圖自主研發的浸沒式液冷技術,能夠為企業提(tí)供更節能、高效的液冷數據中心建設(shè)及改造方案。經工業和信息(xī)化部電子第五研究所(中國賽寶實驗室)數(shù)據中心(xīn)能效評估,綠色雲圖自主研發的液冷數據中心PUE均值低至1.049。(行業新玩家)

潤澤科技:公司已經開(kāi)始批量交付液冷機櫃,正在交付(fù)的以10kw左右的高密機(jī)櫃為主,以及20kw以上的液冷機櫃。公司將(jiāng)加快推(tuī)進高密機櫃和液(yè)冷(lěng)機櫃應用,快速實現整棟液冷數據中心正式投運,向智算中心和(hé)超算中心快速演進,形成數據中心、智算中(zhōng)心(xīn)和超算中心融(róng)合的綜合算力中心。(行業新(xīn)玩家)

烽火通信:公司全新一代 FitNeo LCS 液冷解決方案,專為高熱密(mì)度機櫃綠色低碳運(yùn)營而(ér)設計。FitNeo LCS 通過(guò)芯片級製冷,直接利(lì)用*大溫差快速換熱,實現超低(dī) PUE,CLF 低(dī)至 0.04,功耗降低 5-20%;同時,具有環保無氟、低噪低耗、綠(lǜ)色節能等特點,機組管路通過工廠預製(zhì)模(mó)塊化配裝實(shí)現快速(sù)交付,精減現場動火焊接環節;冷卻液緩蝕抑菌、超低電導,連接部件超高承壓,超低漏率(lǜ),全鏈(liàn)路漏液檢測可自(zì)動上報。(行業(yè)新玩家(jiā))

銳新科技:公司鋁合金散熱器應用在液冷服務器中。在光模塊的冷卻中,通過對鋁合金基座進行直接水冷散熱的,而光學元件是裝在基板上工作(zuò),所產生的熱量是由基座吸收,從達到散熱的目的。公司鋁合金散熱器應用在液冷服務器光模塊的冷卻。(液冷材料)

科華數據:目前公司自主研(yán)發的(de)液冷(lěng)技術(shù)已運用(yòng)在公(gōng)司數據中心及儲能產品、解決方(fāng)案中。領先的產品和技(jì)術是公司的長期核心競爭力,公司持續跟進客戶的技術產品需求,做好相關技術儲備,保持自身技術的(de)領先性(xìng)。(液冷零部件)

歐陸通:公司為阿裏巴巴定製的新一代浸(jìn)沒式液冷集(jí)中式供電電源(yuán)在雲棲大會(huì)展出,應(yīng)用(yòng)於磐久服務器供電係統。該電源(yuán)方案包(bāo)括晨沒式液冷的ATS 2.5KW PSU 和30kw Power Shef,由歐陸通子公司雲電科技自主研發及生產,進入準量產階段。該加工結合了浸沒(méi)式液冷+集中式供電的雙重優勢(shì),帶ATS部件整機效率高達97%。(液冷零部件)

中石科技:公司宜興子公司主營產品包括(kuò)液冷(lěng)模組等,建立相關技(jì)術儲備和產品線,為國內外多家服務器企業提供液冷等全方位的管理綜合解決方案。(液冷(lěng)零(líng)部件)

科創新源:公司研發的(de)數據中心服務器特種散熱模組可滿足客戶在高算力場景下,高功耗半導體芯(xīn)片的散熱效能,該項目已完成樣品試製(zhì)並已通過驗證。公司(sī)控股子公司蘇州瑞泰克散(sàn)熱科技有限(xiàn)公司主要產品包括冷凝(níng)器、蒸(zhēng)發器以及散熱液冷板等熱管(guǎn)理係統產品。(液冷(lěng)零部件(jiàn))

高瀾股份:公司服務(wù)器液冷業務擁有三種解決方案:冷板(bǎn)式液冷、浸沒式液冷和集裝箱式液冷,可有效降低大型數據中心(xīn)的PUE(數據中心總設備能耗/IT設備能耗)。(液冷零部件)

康盛股份:公司新一代數據中心(xīn)機(jī)房建設完成並投入使用,標誌著康盛(shèng)股份在液冷溫(wēn)控領域實現(xiàn)新突破,邁上新台階。康盛(shèng)股份標準化浸(jìn)沒式(shì)液(yè)冷機(jī)房IT設備(bèi)功率130kW,可提供2P算力(lì)。液冷機房建設(shè)主要依據GB50174-2017和液冷數據(jù)中心技術(shù)規範(康盛股份參編行業標準)。康盛股份標準化浸沒(méi)式液冷機房配3台30kW 42U高性能液冷機櫃、2台20kW 21U高性(xìng)能液冷機(jī)櫃。目前運(yùn)行服務(wù)器主要有新華三5315Y服務器和DELL R760服務器。(液冷零部件)

精研科技:公司可為消費電子(zǐ)、通信、激光投影、服務器等領域客戶提供風冷(lěng)模組(zǔ)、液冷模(mó)組、液冷板以及(jí)模組子件熱管、VC等散熱(rè)部品。(液冷零部件)

華勤技術:公司已於2021年取得(dé)液冷裝置及設備的實用新型**,並在散(sàn)熱方麵取得了數據產品散熱核心(xīn)技術。目前在(zài)部分的人(rén)工(gōng)智能服務器上使用液冷散熱技術。(液(yè)冷零部件)

銳捷網絡:司在業界(jiè)進行了NPO、液冷等創新技術的探索和(hé)市場實踐。公司與頭部互(hù)聯網(wǎng)客戶聯合發布了在大型數據中心規模部署的浸沒式液冷交換機,提升了數據中心網絡的可靠性和能源效率;去年,公司(sī)發布了同時應用NPO矽光和冷板式液(yè)冷技術的 51.2T NPO矽(guī)光交(jiāo)換機,推動(dòng)數(shù)據中心網絡建設更加綠色低碳化(huà)。(液冷零(líng)部件)

飛榮達:公司針對服務器上的散熱需求還開發了軸流(liú)風扇,特(tè)種散熱器,單相液冷冷板模組,兩相液冷模組等產(chǎn)品。(液冷零部件)

強瑞技術:公司CDU(液冷分配單元(yuán))單機已通(tōng)過客戶(hù)測試並生產。(液冷零部件)

申菱(líng)環(huán)境:公司致力於緊跟(gēn)客戶步伐,通過高能效,可靠(kào)的(de)新一代溫控產品如DPC相變冷卻(què)係統(tǒng),新(xīn)型高效蒸發冷卻係統,液(yè)冷溫控係統等產品和解決方案服務客戶。(液冷零部件(jiàn))

英維克(kè):公司在算力行業應用的(de)液冷全鏈條解決方案已有成熟、完整布局,未來(lái)由於AI算力的增長勢必(bì)拉動相關的業務增(zēng)長。(液冷零部件)

同方股(gǔ)份:公司(sī)目前有基於華為昇騰的AI服務器可提供液冷解決方案。(華為)

朗威股份:公司是一家數據中心機房及綜合(hé)布線設備提供商,主營業務(wù)是服務器機櫃、冷熱通道、微(wēi)模塊(kuài)、T-block機架等數據中心機櫃和綜合布線產品的研發、生產、銷售及(jí)服務。2022年(nián)公司液(yè)冷機櫃產品銷售收(shōu)入占數據中心機櫃銷售總(zǒng)額的比例為3.79%。(液冷零部件)

神州數碼:公司目前正在進行液冷整機櫃(guì)產品的(de)需求設計和(hé)開發。目前液冷共有兩種主流的技術方案,分別是浸沒方案和冷板方案,分(fèn)別適(shì)用於不同的數據中心場景,公司當前規劃的液冷整機(jī)櫃產品會基於冷板開發。(液冷零部件)

雙良節能:公司(sī)CDM液冷換熱模塊涉(shè)及全浸沒式液冷服務器換熱模塊與尾端冷卻塔設備,近年來一直獲有優質客戶的訂單。(液冷零部件)

[聲(shēng)明]文章係本網編輯(jí)轉載(zǎi),轉載目的在(zài)於傳遞更多(duō)行業新聞信息,文章僅作交流學習使用,也並(bìng)不代表本網讚同其(qí)觀點和對其真實性負責。如涉及(jí)作品內(nèi)容、版權和其它問題(tí),請在30日內與(yǔ)本網聯係,我們將(jiāng)在**時間刪除內容!

本站文章版權歸(guī)原作(zuò)者所有 內容為作者個人觀點 本站隻提供參考並不構成任何投資及應用建議。本(běn)站(zhàn)擁有對此聲明的*終解釋權。

0519-82989061

0519-82989061